Introduzione agli algoritmi di data science

Una descrizione di alto livello degli algoritmi essenziali utilizzati in Data Science. Come già sapete, la scienza dei dati è un campo di studio in cui le decisioni vengono prese sulla base delle intuizioni che otteniamo dai dati anziché dai classici approcci deterministici basati su regole. In genere possiamo dividere un'attività di apprendimento automatico in tre parti

- Ottenere i dati e mappare il problema aziendale,

- Applicazione di tecniche di apprendimento automatico e osservazione della metrica delle prestazioni

- Test e distribuzione del modello

In questo intero ciclo di vita, utilizziamo vari algoritmi di data science per risolvere il compito da svolgere. In questo articolo, divideremo gli algoritmi più comunemente usati in base ai loro tipi di apprendimento e avremo una discussione di alto livello su quelli.

Tipi di algoritmi di scienza dei dati

Sulla base delle metodologie di apprendimento possiamo semplicemente dividere gli algoritmi di machine learning o data science nei seguenti tipi

- Algoritmi supervisionati

- Algoritmi senza supervisione

1. Algoritmi supervisionati

Come suggerisce il nome, gli algoritmi supervisionati sono una classe di algoritmi di apprendimento automatico in cui il modello viene addestrato con i dati etichettati. Ad esempio, in base ai dati storici, si desidera prevedere che un cliente eseguirà il default o meno di un prestito. Dopo la preelaborazione e la progettazione delle caratteristiche dei dati etichettati, gli algoritmi supervisionati vengono addestrati sui dati strutturati e testati su un nuovo punto dati o in questo caso per prevedere un default del prestito. Tuffiamoci negli algoritmi di apprendimento automatico supervisionato più popolari.

- K vicini più vicini

K vicini più vicini (KNN) è uno degli algoritmi di machine learning più semplici ma potenti. È un algoritmo supervisionato in cui la classificazione viene effettuata in base a k punti dati più vicini. L'idea alla base di KNN è che punti simili sono raggruppati insieme, misurando le proprietà dei punti dati più vicini possiamo classificare un punto dati di test. Ad esempio, stiamo risolvendo un problema di classificazione standard in cui vogliamo prevedere che un punto dati appartiene alla classe A o alla classe B. Lasciamo k = 3, ora testeremo 3 punti dati più vicini del punto dati test, se due di essi appartengono alla classe A dichiareremo il punto di dati del test come classe A, altrimenti la classe B. Il valore corretto di K si trova attraverso la convalida incrociata. Ha una complessità temporale lineare quindi non può essere utilizzata per applicazioni a bassa latenza.

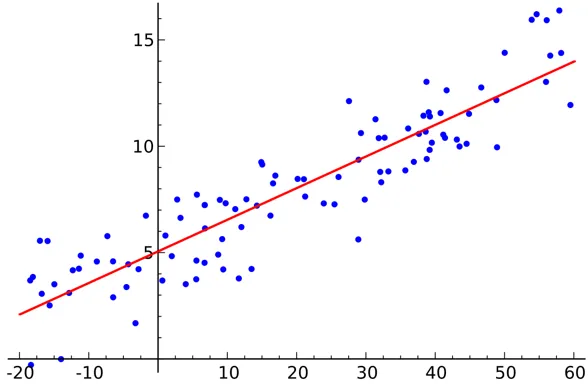

- Regressione lineare

La regressione lineare è un algoritmo di scienza dei dati supervisionato.

Produzione:

La variabile è continua. L'idea è quella di trovare un iperpiano in cui il numero massimo di punti si trova nell'iperpiano. Ad esempio, la previsione della quantità di pioggia è un problema di regressione standard in cui è possibile utilizzare la regressione lineare. La regressione lineare presuppone che la relazione tra le variabili indipendenti e dipendenti sia lineare e che la multicollinearità sia molto scarsa o nulla.

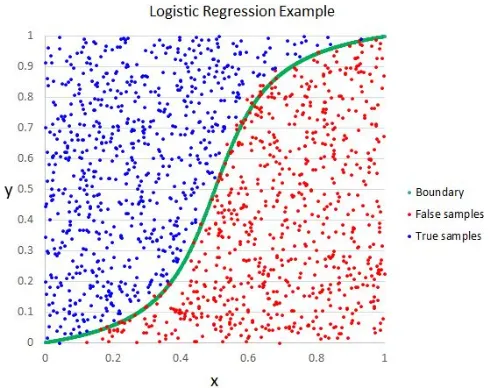

- Regressione logistica

Sebbene il nome indichi regressione, la regressione logistica è un algoritmo di classificazione supervisionato.

Produzione:

L'intuizione geometrica è che possiamo separare diverse etichette di classe usando un limite di decisione lineare. La variabile di output della regressione logistica è categorica. Si noti che non è possibile utilizzare l'errore quadratico medio come funzione di costo per la regressione logistica in quanto non è convesso per la regressione logistica.

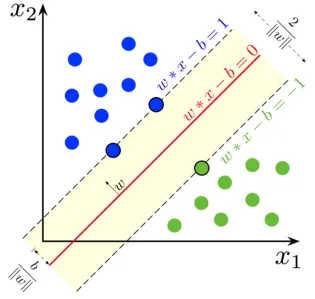

- Support Vector Machine

Nella regressione logistica, il nostro motto principale era trovare una superficie lineare di separazione.

Produzione:

Possiamo considerare la macchina vettoriale di supporto come un'estensione di questa idea in cui dobbiamo trovare un iperpiano che massimizzi il margine. Ma cos'è un margine? Per un vettore W (la superficie decisionale che dobbiamo trovare), disegniamo due linee parallele su entrambi i lati. La distanza tra queste due linee è chiamata margine. SVM presume che i dati siano separabili linearmente. Sebbene possiamo usare SVM per dati non lineari anche usando il trucco del kernel.

- Albero decisionale

Decision Tree è un classificatore nidificato basato su If-Else che utilizza una struttura grafica simile ad un albero per prendere la decisione. Gli alberi decisionali sono molto popolari e uno degli algoritmi di apprendimento automatico supervisionato più utilizzati nell'intera area della scienza dei dati. Fornisce una migliore stabilità e precisione nella maggior parte dei casi rispetto ad altri algoritmi supervisionati e robusti per i valori anomali. La variabile di output dell'albero decisionale è generalmente categorica, ma può anche essere utilizzata per risolvere i problemi di regressione.

- Gruppo musicale

Gli ensemble sono una categoria popolare di algoritmi di data science in cui più modelli vengono utilizzati insieme per ottenere prestazioni migliori. Se hai familiarità con Kaggle (una piattaforma di Google per esercitarsi e competere nelle sfide della scienza dei dati), scoprirai che la maggior parte delle soluzioni vincitrici utilizza un qualche tipo di ensemble.

Possiamo dividere approssimativamente gli ensemble nelle seguenti categorie

- insacco

- Aumentare

- stacking

- Cascading

Foresta casuale, alberi di decisione che aumentano il gradiente sono esempi di alcuni algoritmi di ensemble popolari.

2. Algoritmi senza supervisione

Gli algoritmi senza supervisione vengono utilizzati per le attività in cui i dati non sono etichettati. Il caso d'uso più popolare di algoritmi senza supervisione è il clustering. Il clustering è il compito di raggruppare punti dati simili senza intervento manuale. Parliamo qui di alcuni dei più diffusi algoritmi di apprendimento automatico senza supervisione

- K significa

K Means è un algoritmo randomizzato senza supervisione utilizzato per il clustering. K Means segue i passaggi seguenti

1. Inizializza i punti K in modo casuale (c1, c2..ck)

2. Per ciascun punto (Xi) nel set di dati

Seleziona Ci più vicino (i = 1, 2, 3..k)

Aggiungi Xi a Ci

3. Ricalcola il centroide usando le metriche appropriate (ovvero la distanza intracluster)

4, Ripetere il passaggio (2) (3) fino alla convergenza

- K significa ++

La fase di inizializzazione in K significa che è puramente casuale e in base all'inizializzazione, il clustering cambia drasticamente. K significa ++ risolve questo problema inizializzando k in modo probabilistico invece di pura randomizzazione. K significa che ++ è più stabile del classico K.

- K medoidi:

K medoids è anche un algoritmo di clustering basato su K significa. La differenza principale tra i due è che i centroidi di K significano che non esiste necessariamente nel set di dati che non è il caso dei medoidi K. I medoidi K offrono una migliore interpretabilità dei cluster. K significa minimizzare l'errore al quadrato totale, mentre i medoidi K minimizzano la differenza tra i punti.

Conclusione

In questo articolo, abbiamo discusso degli algoritmi di machine learning più popolari utilizzati nel campo della scienza dei dati. Dopo tutto questo, ti potrebbe venire in mente una domanda: ' Quale algoritmo è il migliore? ' Chiaramente non c'è vincitore qui. Dipende esclusivamente dal compito da svolgere e dai requisiti aziendali. Come best practice inizia sempre con l'algoritmo più semplice e aumenta gradualmente la complessità.

Articoli consigliati

Questa è stata una guida agli algoritmi di data science. Qui abbiamo discusso di una panoramica degli algoritmi di data science e di due tipi di algoritmi di data science. Puoi anche consultare i nostri articoli per saperne di più-

- Piattaforma di data science

- Lingue per la scienza dei dati

- Algoritmi di classificazione

- Algoritmi di data mining

- Tecniche più utilizzate per l'apprendimento degli ensemble

- Modi semplici per creare l'albero decisionale

- Guida completa del ciclo di vita di Data Science