Introduzione ai comandi di Hadoop fs

In questo articolo, esamineremo i comandi di gestione dei file di HADOOP, che viene utilizzato per gestire i file tramite la console.

Avrai bisogno di un sistema Linux e dell'ultima versione di Hadoop. Per stampare la versione di Hadoop, per sapere da chi è stata creata la versione, il valore di checksum è sufficiente eseguire il comando seguente dopo aver effettuato l'accesso alla piattaforma Hadoop.

Comando: versione di Hadoop

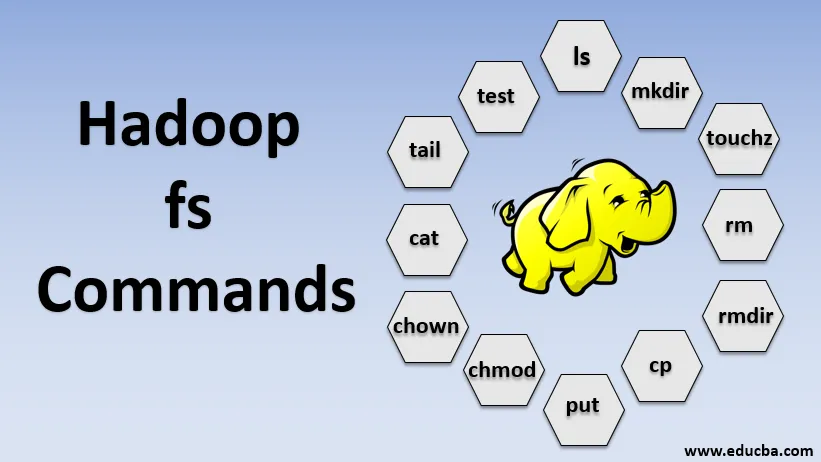

Comandi di Hadoop fs

Ora impariamo come usare i comandi di HADOOP fs.

Inizieremo con le basi. Digita questi comandi in PUTTY o in qualsiasi console con cui ti trovi a tuo agio.

1. hadoop fs -ls

Per una directory, restituisce l'elenco di file e directory mentre, per un file, restituisce le statistiche sul file.

hadoop fs -lsr: serve per elencare ricorsivamente directory e file in cartelle specifiche.

- Esempio : hadoop fs -ls / o hadoop fs -lsr

- -d: questo è usato per elencare le directory come file semplici.

- -h: viene utilizzato per formattare le dimensioni dei file in modo leggibile dall'uomo rispetto al solo numero di byte.

- -R: viene utilizzato per elencare in modo ricorsivo il contenuto delle directory.

2. hadoop fs -mkdir

Questo comando prende il percorso come argomento e crea directory in hdfs.

- Esempio : hadoop fs -mkdir / user / datahub1 / data

3. hadoop fs -touchz

Crea un file vuoto e non utilizza spazio

- Esempio: hadoop fs -touchz URI

4. hadoop fs -rm

Elimina i file specificati come argomento. Dobbiamo specificare l'opzione -r per eliminare l'intera directory. E se viene specificata l'opzione -skipTrash, salterà il cestino e il file verrà eliminato immediatamente.

- Esempio : hadoop fs -rm -r /user/test1/abc.text

5. hadoopfs -rmdir

Rimuove i file e le autorizzazioni di directory e sottodirectory. Fondamentalmente è la versione estesa di Hadoop fs -rm.

6. hadoop fs -cp

Copia il file da un percorso all'altro

- Esempio : hadoop fs -cp /user/data/abc.csv / user / datahub

7. hadoop fs -copyFromLocal

Copia il file da edgenode a HDFS.

8. hadoop fs -put

Copia il file da edgenode a HDFS, è simile al comando precedente ma put legge anche l'input dallo stdin di input standard e scrive su HDFS

- Esempio : hadoop fs -put abc.csv / user / data

hadoop fs -put -p: il flag conserva l'accesso, i tempi di modifica, la proprietà e la modalità.

hadoop fs -put -f: questo comando sovrascrive la destinazione se il file esiste già prima della copia.

9. hadoop fs -moveFromLocal

È simile alla copia da locale, tranne per il fatto che il file di origine viene eliminato da edgenode locale dopo essere stato copiato in HDFS

- Esempio : fs -moveFromLocal abc.text / user / data / acb.

10. hadoop fs -copyToLocal

Copia il file da HDFS a edgenode.

- Esempio : fs -copyToLocal abc.text / localpath

11. hadoop fs -chmod

Questo comando ci aiuta a cambiare l'accesso a un file o una directory

- Esempio : hadoop fs -chmod (-R) (percorso)

12. hadoop fs -chown

Questo comando ci aiuta a cambiare la proprietà di un file o directory

- Esempio : hadoop fs -chown (-R) (OWNER) (:( GROUP)) PERCORSO

13. hadoop fs -cat

Stampa il contenuto di un file HDFS sul terminale

- Esempio : hadoop fs -cat /user/data/abc.csv

14. hadoop fs -tail

Visualizza gli ultimi KB del file HDFS sullo stdout

- Esempio : hadoop fs -tail / in / xyzfile

15. hadoop fs -test

Questo comando viene utilizzato per le operazioni di test dei file HDFS, restituisce 0 se vero.

- - e: controlla se il file esiste.

- -z: controlla se il file è di lunghezza zero

- -d / -f: controlla se il percorso è rispettivamente directory / file

Qui, discutiamo un esempio in dettaglio

- Esempio : hadoop fs -test - (defz) /user/test/test1.text

16. hadoop fs -du

Visualizza le dimensioni dei file e delle directory contenute nella directory specificata o la lunghezza di un file nel caso sia un file

17. hadoop fs -df

Visualizza spazio libero

18. hadoop fs -checksum

Restituisce le informazioni di checksum di un file

19. hadoop fs -getfacl

Visualizza l'elenco di controllo di accesso (ACL) del file o della directory particolare

20. hadoop fs -count

Conta il numero di directory, file e byte nel percorso che corrisponde al modello di file specificato.

21. hadoop fs -setrep

Modifica il fattore di replica di un file. E se il percorso è una directory, il comando modifica il fattore di replica di tutti i file nella directory.

- Esempio : hadoop fs -setrep -R / user / datahub: viene utilizzato per accettare la funzionalità di arretramento e non ha alcun effetto.

hadoop fs - setrep -w / user / datahub : attende il completamento della replica

22. hadoop fs -getmerge

Concatena i file HDFS nell'origine nel file locale di destinazione

- Esempio : hadoop fs -getmerge / user / datahub

23. hadoop fs -appendToFile

Aggiunge una singola o più origini dal file system locale alla destinazione.

- Esempio : hadoop fs -appendToFile xyz.log data.csv / in / appendfile

24. hadoop fs -stat

Stampa le statistiche sul file o sulla directory.

- Esempio : hadoop fs -stat (formato)

Conclusione - Hadoop fs Commands

Quindi, abbiamo esaminato quasi tutti i comandi necessari per la gestione dei file e visualizzare i dati all'interno dei file. Ora puoi modificare i tuoi file e inserire i dati nella piattaforma Hadoop.

Articoli consigliati

Questa è una guida ai comandi di Hadoop fs. Qui discutiamo l'introduzione ai comandi di Hadoop fs insieme al suo esempio in dettaglio. Puoi anche consultare i seguenti articoli per saperne di più-

- Installa Hadoop

- Strumenti di Hadoop

- Architettura di Hadoop

- Componenti Hadoop

- Comandi fs di Hadoop