Differenza tra Hadoop e SQL

Gli enormi dati generati ogni secondo tramite social media come Facebook, Twitter e Instagram hanno spianato la strada allo sviluppo di Hadoop / Big Data Ecosystem. Il termine "3V" riferito a Volume, Velocity e Veracity definisce l'importanza di Hadoop nella gestione dei dati di streaming. Oggi, i dati sono generati da più fonti che devono essere integrati per vari scopi come Reporting, Analisi dei dati e Ricerca e per l'archiviazione centralizzata dei dati. Quando lo facciamo, sorgono numerosi problemi con approcci tradizionali come spazio, accesso, integrità, struttura e larghezza di banda. Per gestire tutti questi problemi, Hadoop fornisce un framework che consente di elaborare i dati con dimensioni enormi, per fornire un facile accesso, elevata disponibilità e caricare i dati in modo dinamico. Dispone di un framework di file system distribuito (HDFS) per l'archiviazione dei dati e del processore di query integrato chiamato "Map Reduce" per l'analisi e l'elaborazione dei dati archiviati in HDFS.

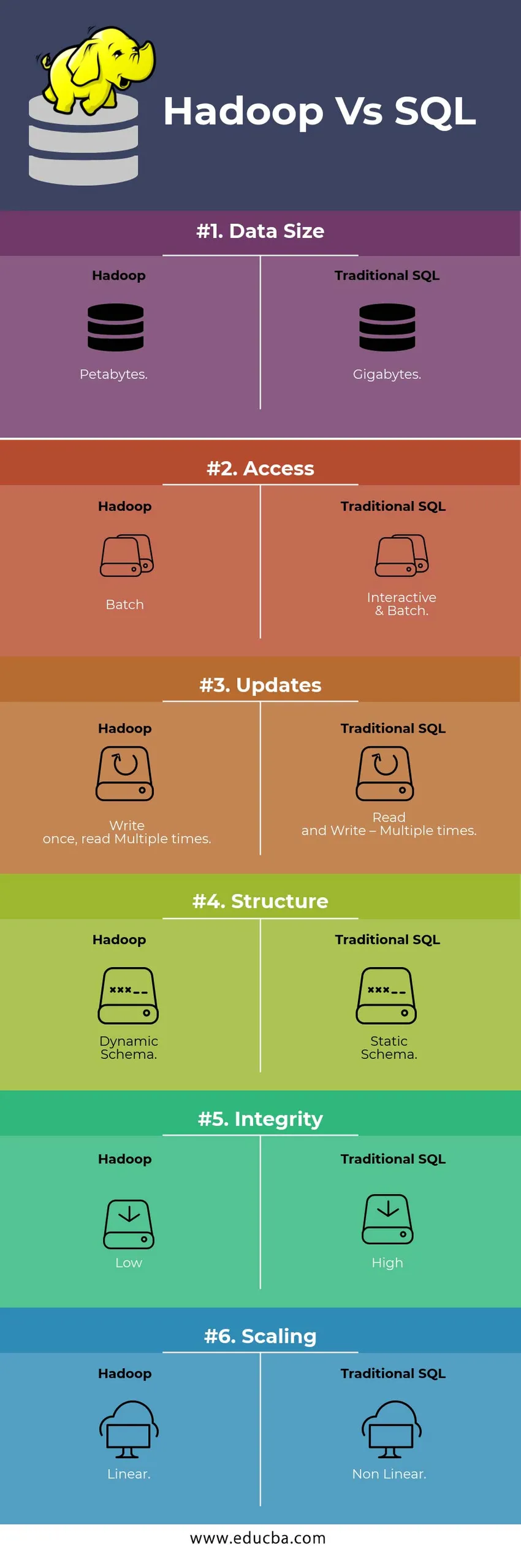

HEAD TO HEAD Confronto tra Hadoop Vs SQL

Di seguito è la 6 differenza principale tra Hadoop Vs SQL

Differenze chiave tra Hadoop Vs SQL

Di seguito è la differenza tra Hadoop e SQL sono i seguenti

- Schema su WRITE Vs READ

Generalmente in un database tradizionale, durante il caricamento / migrazione dei dati da un database a un altro, segue lo schema dell'approccio Scrittura. Ciò rende il processo di caricamento dei dati eccitato / interrotto e comporta il rifiuto dei record a causa di una differenza nella struttura delle tabelle di origine e di destinazione, mentre nel sistema Hadoop tutti i dati sono archiviati in HDFS e i dati sono centralizzati.

Il framework Hadoop viene utilizzato principalmente per il processo di analisi dei dati. Pertanto supporta tutte e tre le categorie di dati, ovvero dati strutturati, semi-strutturati e non strutturati e consente lo schema sull'approccio alla lettura.

- I dati strutturati hanno un formato definito. g .: file XML.

- I dati di Semi Structures sono più liberi; Potrebbe / non avere uno schema. g .: foglio di calcolo

- I dati non strutturati non hanno una struttura o uno schema specifici. Ad esempio: testo normale o immagine.

Hadoop funziona in modo efficiente con dati non strutturati in quanto ha la capacità di interpretare i dati durante il tempo di elaborazione.

| Approccio | Vantaggio | Vantaggio |

| Schema in scrittura | · Strutture predefinite

· Lettura più veloce. Ad esempio: RDBMS tradizionale. | Caricamento lento dei dati

Alta latenza |

| Schema in lettura | · Struttura dinamica

· Scrittura e lettura veloci. Ad esempio: Hadoop | Caricamento veloce dei dati

Bassa latenza |

Tabella : Schema su WRITE VS Schema su READ.

- SCALABILITÀ E COSTI

Hadoop Framework è progettato per elaborare un grande volume di dati. Ogni volta che la dimensione dei dati aumenta, un numero di risorse aggiuntive come il nodo dati può essere aggiunto molto facilmente al cluster rispetto all'approccio tradizionale dell'allocazione della memoria statica. Il tempo e il budget sono relativamente molto inferiori per la loro implementazione e Hadoop fornisce anche la posizione dei dati in cui i dati sono resi disponibili nel nodo che ha eseguito il lavoro.

- TOLLERANZA DI GUASTO

Nel RDBMS tradizionale, quando i dati vengono persi a causa di corruzione o problemi di rete, sono necessari più tempo, costi e risorse per recuperare i dati persi. Tuttavia, Hadoop ha un meccanismo in cui i dati hanno un fattore di replica minimo di tre livelli per i dati archiviati in HDFS. Se uno dei nodi di dati che contengono dati viene a mancare, i dati possono essere facilmente estratti da altri nodi di dati con elevata disponibilità di dati. Quindi rende i dati prontamente disponibili per l'utente indipendentemente da qualsiasi errore.

- PROGRAMMAZIONE FUNZIONALE

Hadoop supporta la scrittura di programmazione funzionale in linguaggi come java, scala e python. Per qualsiasi applicazione che richiede funzionalità aggiuntive può essere implementato registrando UDF - Funzioni definite dall'utente in HDFS. In RDBMS non è possibile scrivere UDF e ciò aumenta la complessità della scrittura di SQL. Inoltre, i dati memorizzati in HDFS sono accessibili a tutti gli ecosistemi di Hadoop come Hive, Pig, Sqoop e HBase. Quindi, se l'UDF è scritto, può essere utilizzato da qualsiasi delle applicazioni sopra menzionate. Aumenta le prestazioni e il supporto del sistema.

- OTTIMIZZAZIONE

Hadoop archivia i dati in HDFS e Process Map Map Reduce con enormi tecniche di ottimizzazione. Le tecniche più popolari utilizzate per la gestione dei dati stanno utilizzando il partizionamento e il bucket dei dati memorizzati. Il partizionamento è un approccio per la memorizzazione dei dati in HDFS suddividendo i dati in base alla colonna menzionata per il partizionamento. Quando i dati vengono iniettati o caricati in HDFS, identifica la colonna della partizione e inserisce i dati nella directory della partizione interessata. Quindi la query recupera il set di risultati recuperando direttamente i dati dalla directory partizionata. Ciò riduce l'intera scansione della tabella, migliora i tempi di risposta ed evita la latenza.

Un altro approccio si chiama Bucketing dei dati. Ciò consente all'analista di distribuire facilmente i dati tra i nodi di dati. Tutti i nodi avranno un numero uguale di dati distribuiti. La colonna Bucketing è selezionata in modo tale da avere il minor numero di cardinalità.

Questi approcci non sono disponibili nel metodo tradizionale di SQL.

- TIPO DI DATI

In un approccio tradizionale, i tipi di dati supportati sono molto limitati. Supporta solo dati strutturati. Pertanto, per pulire e formattare lo schema dei dati stesso ci vorrà più tempo. Tuttavia, Hadoop supporta tipi di dati complessi come Array, Struct e Map. Ciò incoraggia a utilizzare i diversi tipi di set di dati da utilizzare per il caricamento dei dati. Ad esempio: i dati XML possono essere caricati definendo i dati con elementi XML contenenti tipi di dati complessi.

- COMPRESSIONE DATI

Ci sono tecniche di compressione integrate molto meno disponibili per il sistema di database tradizionale. Ma per il framework Hadoop, ci sono molte tecniche di compressione come gzib, bzip2, LZO e snappy. La modalità di compressione predefinita è LZ4. Anche i tavoli possono essere compressi usando le tecniche di compressione come Parquet, ORC. Le tecniche di compressione aiutano a fare in modo che le tabelle occupino molto meno spazio aumentando il throughput e l'esecuzione più veloce delle query.

Tabella di confronto Hadoop Vs SQL

| caratteristiche | SQL tradizionale | Hadoop |

| Dimensione dei dati | gigabyte | petabyte |

| Accesso | Interattivo e batch | Lotto |

| aggiornamenti | Leggi e scrivi: più volte | Scrivi una volta, leggi più volte |

| Struttura | Schema statico | Schema dinamico |

| Integrità | alto | Basso |

| scalata | Non lineare | Lineare |

Tabella : confronto tra Hadoop tradizionale e SQL Framework.

Conclusione - Hadoop Vs SQL

Nel complesso, Hadoop è all'avanguardia rispetto al tradizionale SQL in termini di costi, tempi, prestazioni, affidabilità, supportabilità e disponibilità dei dati per un gruppo di utenti molto ampio. Al fine di gestire in modo efficiente l'enorme quantità di dati generati ogni giorno, il framework Hadoop aiuta a catturare, archiviare, elaborare, filtrare e infine archiviare in modo tempestivo in un luogo centralizzato.

Articolo raccomandato

- Hadoop vs Hive - Scopri le migliori differenze

- Scopri le 10 utili differenze tra Hadoop e Redshift

- HADOOP vs RDBMS | Conosci le 12 differenze utili

- Apache Hadoop vs Apache Spark | I 10 migliori confronti che devi sapere!

- Hadoop vs Spark: caratteristiche