Cos'è l'ecosistema Apache Hadoop?

Apache Hadoop Ecosystem è un framework o una piattaforma dati open source assegnata per salvare ed esaminare le enormi raccolte di dati non strutturati. In tutto il mondo, ci sono tonnellate di dati provenienti da numerose piattaforme digitali con la tecnologia innovativa leader dei big data. Inoltre, Apache Hadoop è stato il primo a ottenere questo flusso di innovazione.

Cosa comprende l'architettura / ecosistema di dati Hadoop?

L'ecosistema Hadoop non è un linguaggio di programmazione o un servizio, è un framework o una piattaforma che si occupa di problemi relativi ai big data. È possibile identificarlo come una suite che avvolge vari servizi come archiviazione, importazione, manutenzione e analisi al suo interno. Quindi esaminare e ottenere un pensiero conciso su come i servizi funzionano esclusivamente e in collaborazione. L'architettura di Apache Hadoop comprende diverse innovazioni ed elementi di Hadoop attraverso i quali è possibile risolvere efficacemente anche le complicate questioni informative.

Di seguito è la rappresentazione di ogni parte: -

1) Namenode: guida il processo di informazione

2) Datanode: compone le informazioni nella memoria locale. Il salvataggio di tutte le informazioni in un unico punto non è continuamente suggerito, in quanto potrebbe causare la perdita di informazioni in caso di interruzione del servizio.

3) Task tracker: ricevono compiti assegnati al nodo slave

4) Mappa: prende le informazioni da un flusso e ogni linea viene gestita divisa per dividerla in diversi campi

5) Diminuisci: qui i campi, acquisiti tramite Mappa, sono raccolti o collegati tra loro

Apache Hadoop Ecosystem - passo dopo passo

Ogni elemento dell'ecosistema Hadoop, come aspetti specifici sono evidenti. La prospettiva globale sulla struttura di Hadoop offre una notevole qualità a Hadoop Distributed File Systems (HDFS), Hadoop YARN, Hadoop MapReduce e Hadoop MapReduce dall'ecosistema di Hadoop. Hadoop offre persino ogni libreria Java, record Java significativi, riflessione a livello di sistema operativo, vantaggi e script per operare su Hadoop, Hadoop YARN è un metodo per delineare le attività e gestire le risorse. Nella configurazione di Hadoop, l'HDFS offre un passaggio di throughput elevato alle informazioni sull'applicazione e Hadoop MapReduce offre una preparazione parallela basata su YARN di vasti assortimenti di dati.

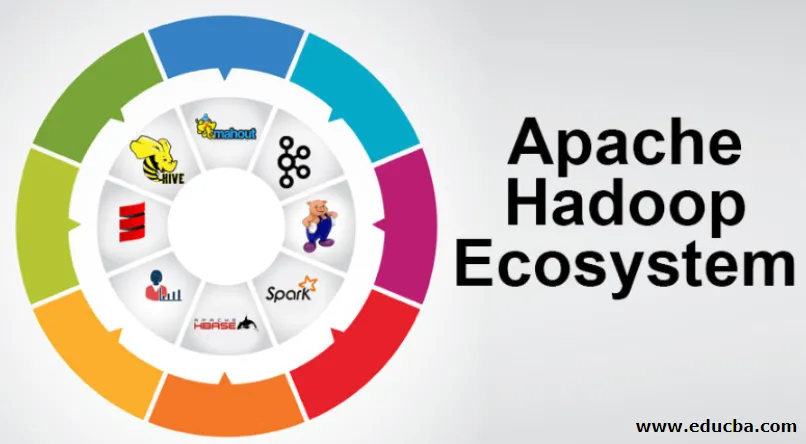

Panoramica sull'ecosistema di Apache Hadoop

È un argomento fondamentale da comprendere prima di iniziare a lavorare con l'ecosistema Hadoop. Di seguito sono riportati i componenti essenziali:

- HDFS: questa è la parte centrale dell'ecosistema Hadoop e può salvare un'enorme quantità di informazioni non strutturate, strutturate e semi-strutturate.

- FILATO: ricorda la mente dell'ecosistema Hadoop e tutta la gestione viene condotta direttamente qui, il che può comprendere l'asset allocation, la pianificazione dei lavori e la preparazione delle azioni.

- MapReduce: è una miscela di due processi, descritti come Mappa e Riduzione e comprende essenzialmente la preparazione di parti che compongono enormi raccolte informative che utilizzano algoritmi paralleli e dispersi all'interno dell'ecosistema Hadoop.

- Apache Pig: è un linguaggio della procedura, che viene utilizzato per le applicazioni di gestione parallela per elaborare vaste raccolte informative in condizioni Hadoop e questo linguaggio è un'opzione per la programmazione Java.

- HBase: è un database open source e non associato o NoSQL. Rafforza tutti i tipi di informazioni, quindi può gestire qualsiasi tipo di informazione all'interno di un framework Hadoop.

- Mahout, Spark MLib: Mahout è utilizzato per l'apprendimento automatico e dà natura alla creazione di applicazioni di apprendimento automatico.

- Zookeeper: per gestire i gruppi, è possibile utilizzare Zookeeper, altrimenti viene chiamato il signore del coordinamento, che può fornire amministrazioni affidabili, rapide e risolte per i gruppi di Hadoop.

- Oozie: Apache Oozie gestisce la pianificazione del lavoro e opera come servizio di allerta e orologio all'interno dell'ecosistema Hadoop.

- Ambari: è un'impresa di Apache Software Foundation e può rendere l'ecosistema Hadoop progressivamente flessibile.

Hadoop YARN:

Pensa a YARN come alla mente del tuo ecosistema Hadoop. Svolge la totalità delle operazioni di elaborazione assegnando risorse e attività di pianificazione.

Ha due segmenti degni di nota che sono ResourceManager e NodeManager.

- ResourceManager: - È di nuovo un nodo importante nella divisione operativa. Ottiene le richieste di preparazione e successivamente passa le informazioni rispettivamente ai NodeManager correlati, dove avviene la gestione autentica.

- NodeManagers: - Questi sono installati su ciascun DataNode. È responsabile dell'esecuzione di un'assegnazione su ciascun DataNode.

Come funziona apache Hadoop?

- È destinato a salire dai singoli server a una grande quantità di macchine, ognuna delle quali fornisce capacità e calcolo locale. Invece di dipendere dall'equipaggiamento per comunicare un'alta accessibilità, la biblioteca stessa ha lo scopo di distinguere e gestire le delusioni a livello di applicazione, trasmettendo così un servizio estremamente accessibile su un gruppo di PC, ognuno dei quali potrebbe essere incline a delusioni.

- Guarda oltre, tuttavia, e sul lavoro si riscontra un notevole aumento del fascino. Hadoop è totalmente modulare, il che implica che puoi scambiare praticamente qualsiasi suo segmento con uno strumento software alternativo. Ciò rende l'architettura straordinariamente adattabile, altrettanto potente ed efficace.

Apache Hadoop Spark:

- Apache Spark è un sistema per l'analisi delle informazioni in tempo reale in un ambiente di calcolo disperso. Implementa calcoli in memoria per aumentare la velocità di gestione delle informazioni.

- È più veloce per la gestione di informazioni su vasta scala in quanto utilizza calcoli in memoria e diversi miglioramenti. Lungo queste linee, richiede un'elevata forza di elaborazione.

Come funziona Apache Pig?

- Apache Pig è un sistema benefico che Yahoo è stato sviluppato per esaminare in modo efficace e senza intoppi vaste posizioni informative. Fornisce un linguaggio di flusso di informazioni di alto livello Pig Latin che è migliorato, estensibile e semplice da usare.

- L'eccezionale componente dei programmi Pig in cui la loro composizione è disponibile per una sostanziale parallelizzazione che semplifica la cura di importanti raccolte di informazioni.

Caso d'uso suino:

- Le informazioni sanitarie private di un individuo sono private e non dovrebbero essere divulgate ad altre persone. Questi dati dovrebbero essere nascosti per mantenere il segreto, tuttavia le informazioni sui servizi medicinali sono enormi al punto che il riconoscimento e l'esclusione delle informazioni sanitarie individuali è essenziale. Apache Pig può essere utilizzato in tali condizioni per riconoscere i dati sanitari.

Conclusione:

- Si delinea di salire da un solo server a un'enorme quantità di macchine, tutte fornendo calcoli e capacità nelle vicinanze. Guarda oltre, tuttavia, e c'è molto più incanto sul lavoro.

- Hadoop è totalmente modulare, il che implica che puoi scambiare praticamente qualsiasi sua parte con uno strumento software alternativo. Ciò rende la struttura straordinariamente adattabile, altrettanto potente ed efficace.

Articoli consigliati

Questa è stata una guida all'ecosistema Apache Hadoop. Qui discutiamo di cosa è l'ecosistema Apache Hadoop? panoramica dell'architettura di Hadoop e funzionamento dell'ecosistema Hadoop. Puoi anche consultare i nostri altri articoli suggeriti per saperne di più -

- Componenti dell'ecosistema Hadoop

- Come installare Apache

- Formazione Apache Spark

- Carriera in Hadoop