Differenza tra TensorFlow vs Spark

Che cos'è TensorFlow?

TensorFlow implica una libreria open source compatibile con Python per il calcolo numerico che esegue l'apprendimento automatico più velocemente e in modo più semplice. TensorFlow consente agli sviluppatori di progettare grafici del flusso di dati, strutture che definiscono il modo in cui i dati si spostano su un grafico, una serie di nodi di elaborazione. Un singolo nodo all'interno di un particolare grafico indica alcune operazioni matematiche. Inoltre, tutti i punti delle associazioni tra i nodi implicano una raccolta preferenziale di dati tensoriale multidimensionale. TensorFlow offre informazioni complete per lo sviluppatore attraverso un linguaggio popolare, Python. Questo linguaggio è semplice da usare e facile da imparare e offre approcci accettabili per rappresentare le astrazioni di alto livello che possono essere collegate ai Tensori e i nodi collettivamente sono oggetti Python in TensorFlow.

Inoltre, le applicazioni di TensorFlow rimangono esse stesse applicazioni Python. In Python, tuttavia, le corrette operazioni matematiche non sono implementate. Le modifiche nelle librerie accessibili tramite TensorFlow sono composte in modo simile ai binari C ++ con prestazioni più elevate. Python fornisce astrazioni di programmazione di alto livello dirigendo direttamente il traffico tra i pezzi e proteggendoli insieme. Le applicazioni di TensorFlow possono essere gestite su quasi tutti i target accessibili: un computer locale, iOS, un cluster nel cloud, CPU o GPU e dispositivi Android. Se il cloud privato di Google è familiare, per un'ulteriore accelerazione, è possibile eseguire il silicio TensorFlow Processing Unit (TPU) personalizzato di Google verso TensorFlow. E poi, I modelli risultanti sviluppati da TensorFlow, tuttavia, possono essere implementati su quasi tutti i dispositivi in cui verranno gestiti per fornire previsioni.

Che cos'è Spark?

Apache Spark è un sistema di elaborazione cluster ad alta velocità più generico. Fornisce API di alto livello in Scala, Python, Java e R e un motore ottimizzato che promuove grafici di esecuzione generali. Aiuta anche un ricco set di strumenti di livello superiore tra cui MLlib per l'apprendimento automatico, GraphX per l'elaborazione di grafici e Spark SQL per SQL e l'elaborazione di dati strutturati, Spark Streaming. Apache Spark ha come base strutturale il set di dati distribuito resiliente (RDD), un multiset di sola lettura di elementi di dati sparsi su un cluster di macchine, che mantiene in modo tollerante ai guasti. In Spark 1.x, RDD ha eseguito l'interfaccia di programmazione dell'applicazione (API) iniziale, tuttavia, a partire dall'utilità Spark 2.x del set di dati, l'API è supportata anche se questa API RDD non è obsoleta. La tecnologia RDD conserva ancora l'API del set di dati. Spark ha anche formato i suoi RDD nel 2012 in risposta alle restrizioni dello standard di elaborazione cluster MapReduce, che impone un'adeguata struttura lineare del flusso di dati sui programmi condivisi: i programmi MapReduce scansionano i dati di input dal disco, mappano una funzione sui dati, riducono i risultati del mappa, inoltre memorizzare i risultati della riduzione verso il disco.

Gli RDD di Spark funzionano in modo sostanzialmente funzionale per i programmi distribuiti che contribuiscono in modo volutamente limitato alla memoria condivisa allocata. Spark promuove l'implementazione di entrambi gli algoritmi iterativi, che visitano il loro set di dati varie volte all'interno di un ciclo, e l'analisi interattiva / esplorativa dei dati, ovvero la query replicata di dati in stile database. La latenza di tali applicazioni può essere ridotta di molti ordini di grandezza associati a un'implementazione di MapReduce (come era popolare negli stack di Apache Hadoop). Con la classe di algoritmi iterativi sono gli algoritmi di base per i sistemi di apprendimento automatico, che hanno creato l'impulso principale per lo sviluppo di Apache Spark.

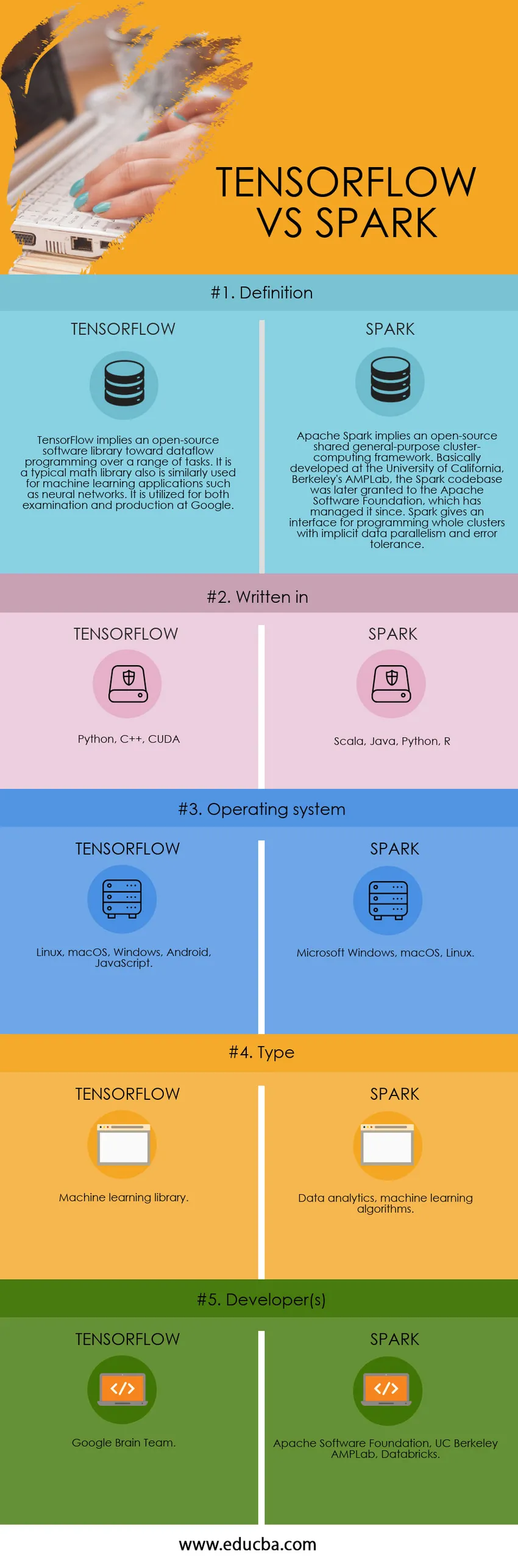

Confronto testa a testa tra TensorFlow vs Spark (infografica)

Di seguito è la principale differenza 5 tra TensorFlow vs Spark

Differenze chiave tra TensorFlow e Spark

Sia TensorFlow vs Spark sono scelte popolari nel mercato; parliamo di alcune delle principali differenze tra TensorFlow e Spark

- Apache Spark preferibilmente Spark in quanto è comunemente noto come un framework di elaborazione cluster open-source che offre un'interfaccia per interi cluster di programmazione con parallelismo implicito dei dati e tolleranza agli errori.TensorFlow, d'altra parte, è una libreria compatta sviluppata da Google che aiuta nel migliorare le prestazioni del calcolo numerico anche nelle reti neurali e nel generare il flusso di dati sotto forma di grafici, costituito da nodi che indicano operazioni e bordi che indicano un array di dati.

- Spark, essenzialmente un ampio framework di dati, ha consentito a un elevato numero di aziende di generare un'enorme quantità di dati utente per elaborarli in modo efficiente, offrendo inoltre raccomandazioni su vasta scala. Considerando che, Tensorflow, essenzialmente una struttura di apprendimento automatico, supporta le persone a creare modelli di apprendimento estesi senza la necessità di rigorose serie di competenze di uno specialista di apprendimento automatico.

- In Spark, un motore veloce e completo per l'elaborazione di dati su larga scala consente varie funzionalità come streaming e analisi sofisticate, alta velocità, facilità d'uso, può connettersi con SQL, può funzionare ovunque come Mesos, Hadoop e cloud. D'altra parte, a Tensorflow, un'API di Google che consente il calcolo su grandi apprendimenti e apprendimento automatico, TensorFlow offre un flusso di calcolo della rappresentazione grafica. L'API incoraggia l'utente a scrivere una complessa progettazione di reti neurali anche sintonizzandola in base ai valori di attivazione.

- Tensorflow scritto in Python, C ++, CUDA. Al contrario, Spark è scritto in Scala, Java, Python, R

- TensorFlow On Spark risolve la difficoltà di distribuire l'apprendimento elevato su cluster di dati significativi in un modo distribuito che non è un paradigma di conoscenza solido completamente moderno, tuttavia preferibilmente un aggiornamento agli attuali quadri che necessitava dello sviluppo di vari programmi per espandere l'intelligence su gruppi di dati significativi. Collegando sia TensorFlow che Spark, offre la possibilità di complessità del sistema indesiderate e latenza di apprendimento end-to-end.

Tabella di confronto TensorFlow vs Spark

Di seguito è riportato il 5 confronto più in alto tra TensorFlow vs Spark

| La base del confronto tra TensorFlow vs Spark |

tensorflow |

SCINTILLA |

| Definizione | TensorFlow implica una libreria software open source per la programmazione del flusso di dati in una serie di attività. È una tipica libreria matematica utilizzata anche per applicazioni di apprendimento automatico come le reti neurali. È utilizzato sia per l'esame che per la produzione presso Google | Apache Spark implica un framework di elaborazione cluster condiviso per scopi generici open source. Fondamentalmente sviluppato presso l'Università della California, AMPLab di Berkeley, la base di codice Spark è stata successivamente concessa alla Apache Software Foundation, che da allora l'ha gestita. Spark fornisce un'interfaccia per la programmazione di interi cluster con parallelismo dei dati implicito e tolleranza agli errori. |

| Scritto in | Python, C ++, CUDA | Scala, Java, Python, R |

| Sistema operativo | Linux, macOS, Windows, Android, JavaScript | Microsoft Windows, macOS, Linux |

| genere | Biblioteca di apprendimento automatico | Analisi dei dati, algoritmi di apprendimento automatico |

| Developer (s) | Google Brain Team | Apache Software Foundation, UC Berkeley AMPLab, Databricks |

Conclusione

In sintesi, Apache Spark implica un framework di elaborazione dei dati, mentre TensorFlow è stato utilizzato per l'apprendimento personalizzato e la progettazione di reti neurali. Pertanto, se un utente richiede l'implementazione di algoritmi di deep learning, TensorFlow è la soluzione e per l'elaborazione dei dati è Spark.

Articoli consigliati

Questa è stata una guida alla differenza principale tra TensorFlow vs Spark. Qui discutiamo anche le differenze chiave tra TensorFlow e Spark con le infografiche e la tabella di confronto. Puoi anche dare un'occhiata ai seguenti articoli per saperne di più.

- Tensorflow vs Pytorch

- Splunk vs Spark

- SOAP vs WSDL

- Hadoop vs Spark

- I 7 migliori metodi architettonici per l'apprendimento profondo