Che cos'è il maiale?

Pig è un motore open source, che fa parte delle tecnologie ecosistemiche di Hadoop. Pig è bravissimo a lavorare con dati che vanno oltre i database tradizionali o i data warehouse. Questo può gestire bene i dati mancanti, incompleti o incoerenti, che non hanno uno schema. Il maiale ha il suo linguaggio per esprimere manipolazioni dei dati, che è latino latino.

Capire il maiale

Pig è una tecnologia che consente di scrivere script di alto livello, ma estremamente granulari, che consente di lavorare con dati in cui lo schema è sconosciuto o incoerente. Pig è una tecnologia open source che gira su Hadoop e fa parte dell'ecosistema Hadoop estremamente vivace e popolare.

Pig funziona bene con dati non strutturati e incompleti, quindi non è necessario disporre del layout tradizionale di regole e colonne per tutto.

È ben definito e può funzionare direttamente sui file in HDFS (Hadoop Distributed File System).

Il maiale sarà la tua tecnologia preferita quando desideri ottenere i dati dall'origine in un data warehouse.

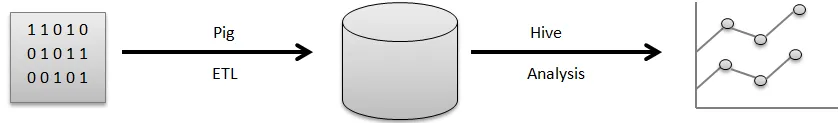

Ad esempio, una pipeline visiva del modo in cui i dati generalmente scorrono prima di poterli utilizzare per generare i grafici carini che si utilizzano per prendere decisioni aziendali.

I dati grezzi provengono da una varietà di fonti, come sensori, telefoni cellulari, ecc. Quindi si utilizzerà Pig per eseguire un'operazione ETL. ETL sta per estrarre, trasformare e caricare, una volta eseguite queste operazioni, i dati ripuliti vengono archiviati in un altro database. Un esempio di tale database sarebbe HDFS, che fa parte di Hadoop. Hive è un data warehouse che verrà eseguito su un file system come questo. Hive è ciò che useresti per l'analisi, per generare i rapporti e per estrarre approfondimenti.

ETL è un passaggio molto importante nell'elaborazione dei dati al fine di ripulire i dati grezzi e nella forma corretta per essere archiviati in un database. L'estrazione si riferisce all'operazione di estrazione di dati non strutturati e incoerenti con campo mancante e valori dalla fonte originale. Transform indica la serie di operazioni da applicare ai dati per ripulirli o scaricarli.

Pre-calcolo di informazioni aggregate utili, elaborazione di campi per abbinare un determinato formato, tutto ciò fa parte della pulizia dei dati dei campi di trasformazione.

Infine, Pig esegue l'operazione di caricamento in cui questi dati puliti sono memorizzati in un database in cui possono essere ulteriormente analizzati. Un esempio di un'operazione standard eseguita da Pig è la pulizia dei file di registro.

Spiega l'architettura del maiale

Ci sono numerose parti di maiale nell'architettura, preferisci:

- Parser : Parser si occupa degli script di maiale, nonché dei controlli di sintassi dello script, del tipo di controllo e di vari controlli assortiti. Inoltre, il loro risultato potrebbe essere un DAG (Directed Acyclic Graph) che di solito indica le affermazioni del latino Pig insieme agli operatori logici.

Inoltre, gli operatori logici con lo script verranno mostrati come i nodi, così come i flussi di dati verranno visualizzati dai bordi attraverso il DAG.

- Ottimizzatore: in seguito, il piano logico (DAG) viene generalmente superato verso l'ottimizzatore logico. Esegue le ottimizzazioni logiche aggiuntive tra cui la proiezione e promuove basso

- Compilatore: anche il compilatore compila il piano logico avanzato in un gruppo di lavori MapReduce.

- Motore di esecuzione: Alla fine, tutte le opere di MapReduce verranno pubblicate su Hadoop in una sequenza ordinata. Alla fine, questo genera i risultati richiesti, sebbene questi lavori di MapReduce saranno eseguiti con Hadoop.

- MapReduce: MapReduce è stato originariamente progettato in Google come un modo per elaborare le pagine Web in modo da potenziare la ricerca di Google. MapReduce distribuisce il calcolo su più macchine nel cluster. MapReduce sfrutta il parallelismo intrinseco nell'elaborazione dei dati. I sistemi moderni, come i sensori o persino gli aggiornamenti dello stato di Facebook, generano milioni di registrazioni di dati non elaborati.

Un'attività con questo livello può essere preparata in due fasi:

- Carta geografica

- Ridurre

Decidi quale logica vuoi implementare in queste fasi per elaborare i tuoi dati.

- HDFS (Hadoop Distributed File System): Hadoop sta permettendo un'esplosione della memorizzazione e dell'analisi dei dati su una scala a capacità illimitata. Gli sviluppatori stanno utilizzando un'applicazione come Pig, Hive, HBase e Spark per recuperare i dati da HDFS.

Caratteristiche

Apache Pig ha le seguenti caratteristiche:

- La semplicità della programmazione: Pig Latin è paragonabile a SQL ed è quindi abbastanza semplice per gli sviluppatori creare uno script Pig. Nel caso in cui tu abbia una conoscenza del linguaggio SQL, è incredibilmente semplice imparare la lingua latina di maiale poiché è proprio come il linguaggio SQL.

- Ricco set di operatori: Pig include una vasta gamma di operatori Rich per essere in grado di eseguire procedure proprio come join, filer, sort e molto altro.

- Possibilità di ottimizzazione: le prestazioni con l'attività in Apache Pig possono essere immediatamente migliorate dall'attività stessa; pertanto gli sviluppatori devono semplicemente concentrarsi sulla semantica di questo linguaggio.

- Estensibilità: utilizzando operatori accessibili, gli utenti possono semplicemente sviluppare le proprie funzioni per leggere, elaborare e scrivere dati.

- Funzioni di definizione dell'utente (UDF): utilizzando il servizio fornito da Pig per la creazione di UDF, siamo in grado di produrre funzioni definite dall'utente sul numero di linguaggi di sviluppo, incluso Java, nonché di invocarle o incorporarle tutte negli script Pig.

A cosa serve il maiale?

Viene utilizzato per l'esame e l'esecuzione di responsabilità, compresa la gestione ad hoc. Apache Pig può essere utilizzato per:

L'analisi con enormi raccolte di dati grezzi preferisce l'elaborazione dei dati per ottenere siti Web di ricerca. Come Yahoo, Google beneficia di Apache Pig per valutare i dati raccolti tramite Google e i motori di ricerca di Yahoo. Gestire raccolte di dati di grandi dimensioni proprio come i record Web, lo streaming di informazioni online e così via. Anche gli aggiornamenti sullo stato di Facebook generano milioni di record di dati non elaborati.

In che modo questa tecnologia ti aiuta a crescere nella tua carriera?

Molte organizzazioni stanno implementando Apache Pig in modo incredibilmente rapido. Ciò significa che le professioni nelle carriere di maiali e suini aumentano ogni giorno. Negli ultimi due anni ci sono stati enormi progressi nello sviluppo di Apache Hadoop. Elementi di Hadoop come Hive, Pig, HDFS, HBase, MapReduce e così via.

Sebbene le offerte di Hadoop siano entrate nel loro secondo decennio in questo momento, sono ancora esplose in riconoscimento durante i precedenti tre o quattro anni. Un gran numero di aziende di software sta applicando i cluster Hadoop in modo incredibilmente comune. Questa può essere sicuramente la parte migliore dei big data. Gli esperti di mira potrebbero diventare esperti in questa eccellente tecnologia.

Conclusione

La competenza di Apache Pig è molto richiesta sul mercato e può continuare ad essere estesa. Comprendendo semplicemente i concetti e facendo esperienza con le migliori abilità di Apache Pig in Hadoop, gli esperti possono svolgere perfettamente la loro professione di Apache Pig.

Articolo raccomandato

Questa è stata una guida a What is Pig? Qui abbiamo discusso i concetti, la definizione e l'architettura con le caratteristiche di Pig. Puoi anche consultare i nostri altri articoli suggeriti per saperne di più -

- Come installare Apache

- Domande di intervista di Apache PIG

- Cosa sono i servizi Web ASP.Net?

- Cos'è la tecnologia Blockchain?