Che cos'è Hadoop?

Prima di comprendere i vantaggi di Hadoop, capire prima di tutto l'Hadoop. Hadoop è un paradigma di elaborazione di grandi quantità di dati che offre un luogo affidabile e scalabile per l'archiviazione e l'elaborazione dei dati. Hadoop è stato creato da Doug Cutting ed è considerato "il padre di Hadoop". Hadoop era il nome dell'elefante giocattolo di suo figlio. Hadoop ha avuto le sue radici nel Nutch Search Engine Project. Hadoop è un framework di elaborazione che ha portato enormi cambiamenti nel modo in cui elaboriamo i dati, nel modo in cui archiviamo i dati. Rispetto ai tradizionali strumenti di elaborazione come RDBMS, Hadoop ha dimostrato che possiamo combattere efficacemente le sfide dei Big Data come,

Varietà di dati: Hadoop può archiviare ed elaborare formati di dati strutturati e semi-strutturati e non strutturati.

Il volume di dati : Hadoop è appositamente progettato per gestire l'enorme volume di dati nella gamma di petabyte.

La velocità dei dati : Hadoop è in grado di elaborare petabyte di dati ad alta velocità rispetto ad altri strumenti di elaborazione come RDBMS, ovvero il tempo di elaborazione in Hadoop è molto inferiore.

Caratteristiche salienti di Hadoop

- Hadoop è di natura open source.

- Funziona su un gruppo di macchine. La dimensione del cluster dipende dai requisiti.

- Può essere eseguito su hardware normale.

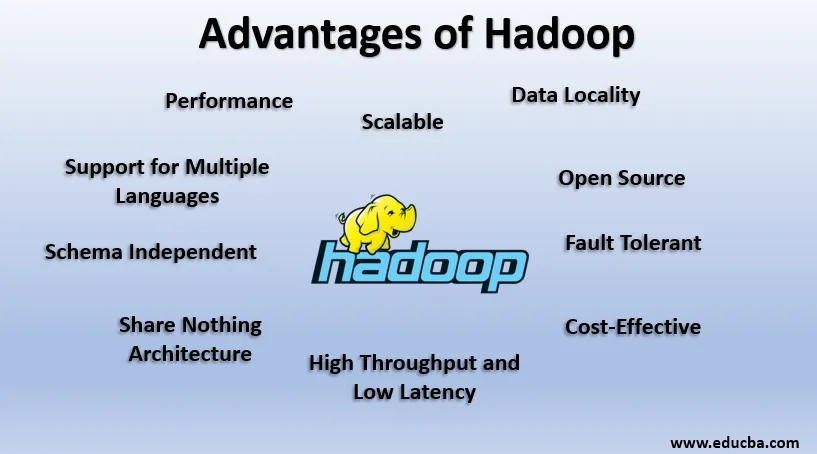

Vantaggi di Hadoop

In questa sezione vengono discussi i vantaggi di Hadoop. Ora diamo un'occhiata a uno a uno:

1. Open Source

Hadoop è di natura open source, ovvero il suo codice sorgente è disponibile gratuitamente. Possiamo modificare il codice sorgente secondo i nostri requisiti aziendali. Sono disponibili anche versioni proprietarie di Hadoop come Cloudera e Horton.

2. Scalabile

Hadoop lavora sul cluster di macchine. Hadoop è altamente scalabile. È possibile aumentare le dimensioni del nostro cluster aggiungendo nuovi nodi secondo i requisiti senza tempi di inattività. Questo modo di aggiungere nuove macchine al cluster è noto come ridimensionamento orizzontale, mentre l'aumento di componenti come il raddoppio del disco rigido e la RAM è noto come ridimensionamento verticale.

3. Tollerante ai guasti

Fault Tolerance è la caratteristica saliente di Hadoop. Per impostazione predefinita, ogni blocco in HDFS ha un fattore di replica di 3. Per ogni blocco di dati, HDFS crea altre due copie e le memorizza in una posizione diversa nel cluster. Se un blocco viene perso a causa di un guasto alla macchina, abbiamo ancora altre due copie dello stesso blocco e quelle vengono utilizzate. In questo modo, la tolleranza agli errori viene raggiunta in Hadoop.

4. Schema indipendente

Hadoop può lavorare su diversi tipi di dati. È abbastanza flessibile per archiviare vari formati di dati e può funzionare sia su dati con schema (strutturato) che senza schema (non strutturato).

5. Alta produttività e bassa latenza

La velocità effettiva indica la quantità di lavoro svolto per unità di tempo e bassa latenza significa elaborare i dati senza ritardi o ritardi. Poiché Hadoop è guidato dal principio dell'archiviazione distribuita e dell'elaborazione parallela, l'elaborazione viene eseguita simultaneamente su ciascun blocco di dati e indipendentemente l'uno dall'altro. Inoltre, invece di spostare i dati, il codice viene spostato nei dati nel cluster. Questi due contribuiscono all'elevata produttività e alla bassa latenza.

6. Posizione dei dati

Hadoop funziona secondo il principio "Sposta il codice, non i dati". In Hadoop, i dati rimangono stazionari e per l'elaborazione dei dati, il codice viene spostato nei dati sotto forma di attività, questo è noto come posizione dei dati. Dato che abbiamo a che fare con dati nell'intervallo di petabyte, diventa difficile e costoso spostare i dati attraverso la rete, la località dei dati garantisce che il movimento dei dati nel cluster sia minimo.

7. Prestazioni

Nei sistemi legacy come RDBMS, i dati vengono elaborati in sequenza, ma in Hadoop l'elaborazione inizia su tutti i blocchi contemporaneamente fornendo così l'elaborazione parallela. Grazie alle tecniche di elaborazione parallela, le prestazioni di Hadoop sono molto più elevate rispetto ai sistemi legacy come RDBMS. Nel 2008, Hadoop ha persino sconfitto il supercomputer più veloce presente a quel tempo.

8. Condividi Nothing Architecture

Ogni nodo nel cluster Hadoop è indipendente l'uno dall'altro. Non condividono risorse o archiviazione, questa architettura è nota come Share Nothing Architecture (SN). Se un nodo nel cluster fallisce, non farà cadere l'intero cluster poiché ogni nodo agisce in modo indipendente eliminando così un singolo punto di errore.

9. Supporto per più lingue

Sebbene Hadoop sia stato sviluppato principalmente in Java, estende il supporto per altre lingue come Python, Ruby, Perl e Groovy.

10. Conveniente

Hadoop è di natura molto economica. Siamo in grado di costruire un cluster Hadoop utilizzando un normale hardware di base, riducendo così i costi dell'hardware. Secondo l'era del Cloud, i costi di gestione dei dati di Hadoop, ovvero sia l'hardware che il software, e le altre spese sono molto minimi rispetto ai sistemi ETL tradizionali.

11. Astrazione

Hadoop fornisce astrazione a vari livelli. Rende il lavoro più semplice per gli sviluppatori. Un file di grandi dimensioni viene suddiviso in blocchi della stessa dimensione e archiviato in posizioni diverse del cluster. Durante la creazione dell'attività di riduzione della mappa, dobbiamo preoccuparci della posizione dei blocchi. Forniamo un file completo come input e il framework Hadoop si occupa dell'elaborazione di vari blocchi di dati che si trovano in posizioni diverse. Hive fa parte dell'ecosistema Hadoop ed è un'astrazione in cima a Hadoop. Poiché le attività Map-Reduce sono scritte in Java, gli sviluppatori SQL in tutto il mondo non sono stati in grado di sfruttare Map Reduce. Quindi, Hive viene introdotto per risolvere questo problema. Possiamo scrivere SQL come query su Hive, che a sua volta attiva i lavori di riduzione della mappa. Quindi, grazie a Hive, la comunità SQL è anche in grado di lavorare su Map Reduce Task.

12. Compatibilità

In Hadoop, HDFS è il livello di archiviazione e Map Reduce è il motore di elaborazione. Ma non esiste una regola rigida secondo cui Map Reduce dovrebbe essere il motore di elaborazione predefinito. I nuovi frame di elaborazione come Apache Spark e Apache Flink utilizzano HDFS come sistema di archiviazione. Anche in Hive possiamo anche cambiare il nostro motore di esecuzione in Apache Tez o Apache Spark secondo i nostri requisiti. Apache HBase, che è NoarQL Columnar Database, utilizza HDFS per il livello di archiviazione.

13. Supporto per vari file system

Hadoop è molto flessibile in natura. Può ingerire vari formati di dati come immagini, video, file, ecc. Può anche elaborare dati strutturati e non strutturati. Hadoop supporta vari file system come JSON, XML, Avro, Parquet, ecc.

Lavorazione di Hadoop

Di seguito sono riportati i punti che mostrano come funziona Hadoop:

1. Archiviazione distribuita ed elaborazione parallela

Questo è il principio guida di tutti i framework dell'ecosistema Hadoop, incluso Apache Spark. Al fine di comprendere il funzionamento di Hadoop e Spark, in primo luogo, dovremmo comprendere cos'è "Archiviazione distribuita ed elaborazione parallela".

2. Archiviazione distribuita

Hadoop non memorizza i dati in un singolo computer, ma li suddivide in blocchi di uguali dimensioni che sono 256 MB per impostazione predefinita e li memorizza in diversi nodi di un cluster (nodi di lavoro). Memorizza i metadati di quei blocchi nel nodo principale. Questo modo di archiviare il file in posizioni distribuite in un cluster è noto come file system distribuito Hadoop - HDFS.

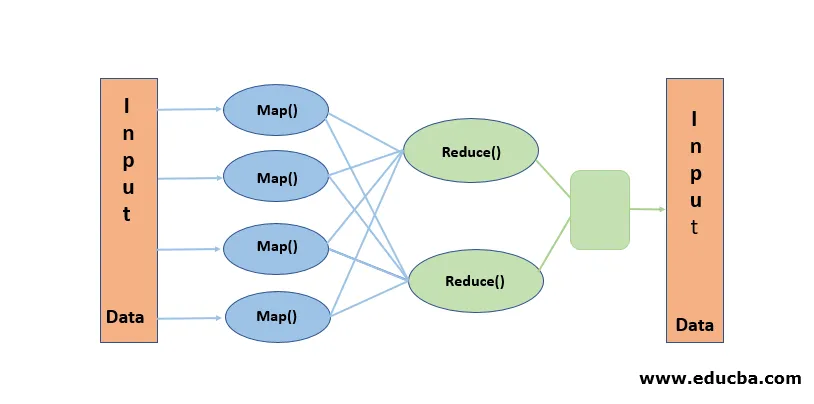

3. Elaborazione parallela

È un paradigma di elaborazione, in cui l'elaborazione viene eseguita contemporaneamente sui blocchi di dati archiviati in HDFS. L'elaborazione parallela si basa sul concetto di "spostare il codice, non i dati". I dati rimangono fissi in HDFS ma il codice viene spostato nei dati per l'elaborazione. In parole povere, se il nostro file viene suddiviso in 100 blocchi, vengono create 100 copie del lavoro che viaggiano attraverso il cluster fino alla posizione in cui risiede il blocco e l'elaborazione su 100 blocchi inizia simultaneamente (fase della mappa). I dati di output di tutti i blocchi vengono raccolti e ridotti all'output finale (fase di riduzione). Map Reduce è considerato "Heart of Hadoop".

Conclusione-Vantaggi di Hadoop

In questa era dei dati, Hadoop ha spianato la strada a un approccio diverso alle sfide poste dai big data. Quando diciamo, Hadoop non intendiamo Hadoop da solo, include strumenti dell'ecosistema Hadoop come Apache Hive che fornisce operazioni simili a SQL su Hadoop, Apache Pig, Apache HBase per il database di archiviazione Columnar, Apache Spark per l'elaborazione in memoria e molti Di Più. Sebbene Hadoop abbia i suoi svantaggi, è altamente adattabile e in continua evoluzione con ogni versione.

Articoli consigliati

Questa è una guida ai vantaggi di Hadoop. Qui discutiamo di cosa sono gli Hadoop e i principali vantaggi di Hadoop. Puoi anche consultare i nostri altri articoli correlati per saperne di più-

- Framework HADOOP

- Che cos'è Hadoop Cluster?

- Che cos'è MapReduce in Hadoop?

- Database Hadoop

- Che cos'è Hadoop? | Applicazioni e funzionalità