Introduzione alla preelaborazione dei dati nell'apprendimento automatico

La preelaborazione dei dati in Machine Learning è un modo per convertire i dati dalla forma grezza in una forma molto più formattata, inutilizzabile o desiderata. È un compito integrale dell'apprendimento automatico svolto dallo scienziato dei dati. Poiché i dati raccolti sono in un formato non elaborato, potrebbe non essere possibile addestrare il modello utilizzandolo. È importante elaborare con cura questi dati non elaborati per interpretarli correttamente ed evitare infine qualsiasi risultato negativo nella previsione. In breve, la qualità del nostro algoritmo di apprendimento dipende fortemente dal tipo di set di dati che abbiamo utilizzato per alimentare il modello, quindi la pre-elaborazione dei dati viene utilizzata per mantenere tale qualità.

I dati raccolti per l'addestramento del modello provengono da varie fonti. Questi dati raccolti sono generalmente nel loro formato non elaborato, ad esempio possono presentare rumori come valori mancanti e informazioni pertinenti, numeri nel formato di stringa, ecc. Oppure non possono essere strutturati. La pre-elaborazione dei dati aumenta l'efficienza e l'accuratezza dei modelli di apprendimento automatico. Poiché aiuta a rimuovere questi rumori e il set di dati e a dare un significato al set di dati

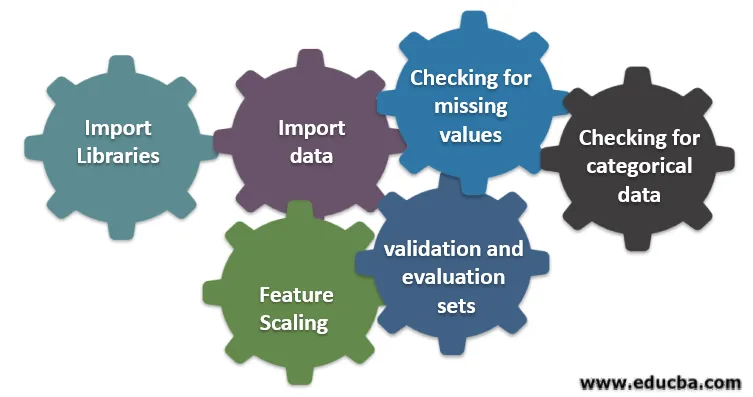

Sei diversi passaggi coinvolti nell'apprendimento automatico

Di seguito sono riportati sei diversi passaggi coinvolti nell'apprendimento automatico per eseguire la pre-elaborazione dei dati:

Passaggio 1: importare librerie

Passaggio 2: importare dati

Passaggio 3: Verifica dei valori mancanti

Passaggio 4: verifica della presenza di dati categorici

Passaggio 5: ridimensionamento delle funzioni

Passaggio 6: suddivisione dei dati in set di formazione, validazione e valutazione

Comprendiamo ciascuno di questi passaggi in dettaglio:

1. Importa librerie

Il primo passo è importare alcune delle librerie importanti richieste nella pre-elaborazione dei dati. Una libreria è una raccolta di moduli che possono essere chiamati e utilizzati. In Python, abbiamo molte librerie che sono utili nella pre-elaborazione dei dati.

Alcune delle seguenti importanti librerie in Python sono:

- Numpy: utilizzava principalmente la libreria per implementare o utilizzare complicati calcoli matematici dell'apprendimento automatico. È utile per eseguire un'operazione su array multidimensionali.

- Panda : è una libreria opensource che offre prestazioni elevate e strumenti di analisi e struttura dei dati facili da usare in Python. È progettato in modo da rendere il lavoro con relazione e dati etichettati semplice e intuitivo.

- Matplotlib: è una libreria di visualizzazione fornita da Python per grafici 2D o array. È costruito su un array intorpidito e progettato per funzionare con uno stack Scipy più ampio. La visualizzazione di set di dati è utile nello scenario in cui sono disponibili dati di grandi dimensioni. I grafici disponibili in matplot lib sono line, bar, scatter, histogram, ecc.

- Seaborn: è anche una libreria di visualizzazione fornita da Python. Fornisce un'interfaccia di alto livello per disegnare grafici statistici interessanti e informativi.

2. Importa set di dati

Una volta importate le librerie, il nostro prossimo passo è caricare i dati raccolti. La libreria Pandas viene utilizzata per importare questi set di dati. Principalmente i set di dati sono disponibili nei formati CSV in quanto di dimensioni ridotte che lo rendono veloce per l'elaborazione. Quindi, per caricare un file CSV usando la funzione read_csv della libreria del panda. Sono disponibili vari altri formati del set di dati

Una volta caricato il set di dati, dobbiamo ispezionarlo e cercare eventuali rumori. Per fare ciò dobbiamo creare una matrice caratteristica X e un vettore di osservazione Y rispetto a X.

3. Verifica dei valori mancanti

Una volta creata la matrice delle caratteristiche, potresti scoprire che mancano alcuni valori. Se non lo gestiremo, potrebbe causare un problema al momento dell'allenamento.

Esistono due metodi per gestire i valori mancanti:

- Rimozione dell'intera riga che contiene il valore mancante, ma potrebbe esserci la possibilità che si finisca per perdere alcune informazioni vitali. Questo può essere un buon approccio se la dimensione del set di dati è grande.

- Se una colonna numerica ha un valore mancante, è possibile stimare il valore prendendo la media, la mediana, la modalità, ecc.

4. Verifica dei dati categorici

I dati nel set di dati devono essere in forma numerica in modo da eseguire il calcolo su di essi. Poiché i modelli di apprendimento automatico contengono calcoli matematici complessi, non possiamo fornire loro un valore non numerico. Pertanto, è importante convertire tutti i valori di testo in valori numerici. La classe di apprendimento LabelEncoder () viene utilizzata per convertire questi valori categoriali in valori numerici.

5. Ridimensionamento delle funzioni

I valori dei dati grezzi variano estremamente e possono comportare una formazione distorta del modello o possono aumentare il costo computazionale. Quindi è importante normalizzarli. Il ridimensionamento delle funzionalità è una tecnica utilizzata per portare il valore dei dati in un intervallo più breve.

I metodi utilizzati per il ridimensionamento delle funzionalità sono:

- Rescaling (normalizzazione min-max)

- Normalizzazione media

- Standardizzazione (normalizzazione del punteggio Z)

- Ridimensionamento in base alla lunghezza dell'unità

6. Suddivisione dei dati in set di formazione, validazione e valutazione

Infine, dobbiamo dividere i nostri dati in tre diversi set, set di training per addestrare il modello, set di validazione per convalidare l'accuratezza del nostro modello e infine set di test per testare le prestazioni del nostro modello su dati generici. Prima di dividere il set di dati, è importante mescolare il set di dati per evitare distorsioni. Una proporzione ideale per dividere il set di dati è 60:20:20, ovvero il 60% come set di training, il 20% come set di test e validazione. Per dividere il set di dati utilizzare train_test_split di sklearn.model_selection due volte. Una volta per dividere il set di dati in treno e set di convalida e quindi per dividere il set di dati del treno rimanente in treno e set di test.

Conclusione - Preelaborazione dei dati nell'apprendimento automatico

La preelaborazione dei dati è qualcosa che richiede pratica. Non è come una semplice struttura di dati in cui apprendi e applichi direttamente per risolvere un problema. Per ottenere una buona conoscenza su come pulire un set di dati o su come visualizzare il set di dati, è necessario lavorare con set di dati diversi.

Più utilizzerai queste tecniche, migliore sarà la comprensione. Questa era un'idea generale di come l'elaborazione dei dati gioca un ruolo importante nell'apprendimento automatico. Oltre a ciò, abbiamo visto anche i passaggi necessari per la pre-elaborazione dei dati. Quindi la prossima volta prima di andare a formare il modello usando i dati raccolti assicurati di applicare la pre-elaborazione dei dati.

Articoli consigliati

Questa è una guida alla preelaborazione dei dati in Machine Learning. Qui discutiamo l'introduzione, sei diversi passaggi coinvolti nell'apprendimento automatico. Puoi anche consultare i nostri altri articoli suggeriti per saperne di più–

- Importanza dell'intelligenza artificiale

- Tecnologia IoT

- Tipi di dati PL / SQL

- Tipi di dati Hive

- R Tipi di dati