Differenza tra Piccoli dati e big data

Small Data, non è altro che i dati che sono sufficientemente piccoli per essere umani in un volume e anche per la formattazione, che li rende accessibili, informativi e fruibili. Il tradizionale trattamento dei dati non può gestire dati grandi o complessi, questi dati sono definiti Big Data. Quando il volume di dati supera un certo limite, i sistemi e le metodologie tradizionali non sono sufficienti per elaborare i dati o trasformarli in un formato utile. Questo è il motivo per cui i dati sono generalmente classificati in due - Piccoli dati contro Big Data

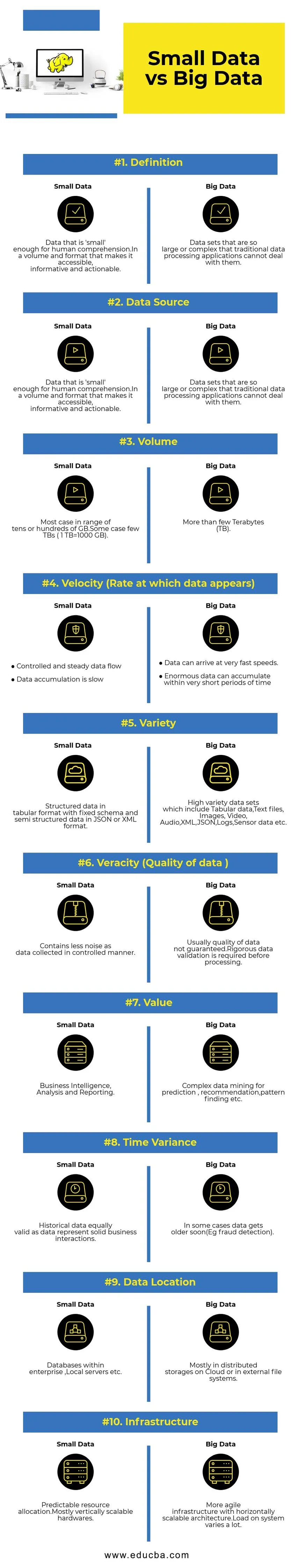

Confronto diretto tra dati di piccole dimensioni e dati di grandi dimensioni (Infografica)

Di seguito sono elencate le 10 principali differenze tra dati di piccole dimensioni e dati di grandi dimensioni

Differenze chiave tra piccoli dati e big data

- Raccolta dei dati : di solito i piccoli dati fanno parte dei sistemi OLTP e raccolti in un modo più controllato, quindi inseriti nel livello di memorizzazione nella cache o nel database. I database avranno repliche di lettura per supportare query di analisi immediate, se necessario. La pipeline di raccolta di Big Data avrà code come AWS Kinesis o Google Pub / Sub per bilanciare i dati ad alta velocità. A valle saranno disponibili pipeline di streaming per analisi in tempo reale e processi batch per l'elaborazione a freddo dei dati.

- Elaborazione dei dati : poiché la maggior parte dei dati di piccole dimensioni generati attraverso il sistema di transazione, le analisi al suo interno saranno per lo più orientate al batch. In alcuni rari casi, le query di analisi vengono eseguite direttamente sui sistemi di transazione. Gli ambienti Big Data avranno pipeline di elaborazione sia in batch che in streaming. Un flusso viene utilizzato per analisi in tempo reale come il rilevamento di frodi con carta di credito o la previsione del prezzo delle azioni. Elaborazione batch utilizzata per implementare complesse logiche aziendali con dati e algoritmi avanzati.

- Scalabilità : i sistemi di dati di piccole dimensioni in genere si adattano verticalmente. Il ridimensionamento verticale sta aumentando la capacità del sistema aggiungendo più risorse alla stessa macchina. Il ridimensionamento verticale è costoso ma meno complesso da gestire. I sistemi di Big Data dipendono principalmente da un'architettura scalabile in orizzontale che offre maggiore agilità a un costo inferiore. Le macchine virtuali preventive disponibili nel cloud rendono i sistemi scalabili orizzontalmente ancora più convenienti.

- Modellazione dei dati : i piccoli dati generati dai sistemi di transazione saranno in forma normalizzata. Le pipeline di dati ETL (Estrai il carico di trasformazione) lo convertono in uno schema a stella o fiocco di neve in un data warehouse. Qui lo schema viene sempre applicato durante la scrittura di dati, il che è relativamente semplice poiché i dati sono più strutturati. Come accennato in precedenza, i dati tabulari sono solo una frazione dei Big Data. Qui i dati vengono replicati molto di più per vari motivi come la consegna degli errori o a causa di alcune limitazioni del motore di database sottostante (ad esempio, alcuni database supportano solo un indice secondario per set di dati). Uno schema non viene applicato durante la scrittura. Invece, uno schema viene convalidato durante la lettura dei dati.

- Accoppiamento di archiviazione e calcolo - Nei database tradizionali che gestiscono principalmente dati di piccole dimensioni, l'archiviazione e l'elaborazione sono strettamente collegate. L'inserimento e il recupero dei dati da e verso il database sono possibili solo attraverso l'interfaccia fornita. I dati non possono essere inseriti direttamente nel filesystem del database, oppure i dati esistenti non possono essere interrogati utilizzando altri motori DB. In realtà, questa architettura aiuta notevolmente a garantire l'integrità dei dati. I sistemi Big Data hanno un accoppiamento molto lento tra archiviazione e elaborazione. Di solito, i dati vengono archiviati in un sistema di archiviazione distribuito come HDFS, AWS S3 o Google GCS e il motore di calcolo per eseguire query sui dati o fare ETL selezionato in un secondo momento. Ad esempio, le query interattive potrebbero essere eseguite utilizzando Presto (Link) ed ETL utilizzando Apache Hive sugli stessi dati.

- Scienza dei dati - Gli algoritmi di machine learning richiedono dati di input in un formato ben strutturato e correttamente codificato, e il più delle volte i dati di input provengono da entrambi i sistemi transazionali come un data warehouse e l'archiviazione di Big Data come un data lake. Gli algoritmi di machine learning eseguiti esclusivamente su Small Data saranno facili in quanto la fase di preparazione dei dati è limitata. Preparare e arricchire i dati nell'ambiente Big Data richiede molto più tempo. I Big Data offrono molte opzioni per la sperimentazione della scienza dei dati a causa dell'elevato volume e varietà di dati.

- Sicurezza dei dati - Pratiche di sicurezza per i piccoli dati che risiedono nel data warehouse aziendale o nei sistemi di transazione forniti dai corrispondenti fornitori di database che potrebbero includere privilegi dell'utente, crittografia dei dati, hash, ecc. La protezione dei sistemi di Big Data è molto più complicata e impegnativa. Le migliori pratiche di sicurezza includono la crittografia dei dati inattivi e in transito, l'isolamento della rete di cluster, regole di controllo dell'accesso rigide, ecc.

Tabella di confronto di piccoli dati e big data

| Base di confronto | Piccoli dati | Big Data |

| Definizione | Dati sufficientemente "piccoli" per la comprensione umana. In un volume e un formato che lo rendono accessibile, informativo e attuabile | Set di dati così grandi o complessi che le tradizionali applicazioni di elaborazione dei dati non possono gestirli |

| Fonte di dati | ● Dati provenienti da sistemi aziendali tradizionali come ○ Pianificazione delle risorse aziendali ○ Gestione delle relazioni con i clienti (CRM) ● Dati finanziari come dati di contabilità generale ● Dati sulle transazioni di pagamento dal sito Web | ● Acquistare i dati dal punto vendita ● Dati click-stream da siti Web ● Dati di flusso GPS: dati di mobilità inviati a un server ● Social media: Facebook, Twitter |

| Volume | La maggior parte dei casi in un intervallo di decine o centinaia di GB. Alcuni casi pochi TB (1 TB = 1000 GB) | Più di alcuni Terabyte (TB) |

| Velocità (velocità con cui vengono visualizzati i dati) | ● Flusso di dati controllato e costante ● L'accumulo di dati è lento | ● I dati possono arrivare a velocità molto elevate. ● Enormi dati possono accumularsi in brevissimi periodi di tempo |

| Varietà | Dati strutturati in formato tabulare con schema fisso e dati semi-strutturati in formato JSON o XML | Set di dati ad alta varietà che includono dati tabulari, file di testo, immagini, video, audio, XML, JSON, registri, dati del sensore ecc. |

| Veracità (qualità dei dati) | Contiene meno rumore dei dati raccolti in modo controllato. | Di solito, la qualità dei dati non è garantita. È necessaria una rigorosa convalida dei dati prima dell'elaborazione. |

| Valore | Business intelligence, analisi e reportistica | Data mining complesso per previsione, raccomandazione, ricerca di schemi, ecc. |

| Scostamento temporale | Dati storici ugualmente validi poiché i dati rappresentano solide interazioni commerciali | In alcuni casi, i dati invecchiano presto (ad es. Rilevamento di frodi). |

| Posizione dei dati | Database all'interno di un'azienda, server locali, ecc. | Principalmente in archivi distribuiti su cloud o in file system esterni. |

| Infrastruttura | Allocazione delle risorse prevedibile Hardware principalmente scalabile verticalmente | Infrastruttura più agile con un'architettura scalabile orizzontalmente. Il carico sul sistema varia molto. |

Conclusione - Piccoli dati contro grandi dati

L'obiettivo finale dell'analisi dei dati è ottenere informazioni tempestive a supporto del processo decisionale. Classificare i dati in piccoli e grandi aiuti per affrontare le sfide nell'analisi dei dati di ciascun mondo separatamente con strumenti adeguati. La linea tra due categorie varia con i sistemi emergenti di elaborazione avanzata dei dati che rendono molto più rapida e complessa anche l'interrogazione dei big data.

Articoli consigliati:

Questa è stata una guida ai piccoli dati rispetto ai grandi dati, al loro significato, al confronto diretto, alle differenze chiave, alla tabella di confronto e alle conclusioni. questo articolo include tutte le differenze importanti tra i piccoli dati e i big data. Puoi anche consultare i seguenti articoli per saperne di più -

- Big Data vs Data Science: come sono diversi?

- Big data: importante per la confluenza di tecnologia e analisi di business

- Le 5 principali tendenze dei big data che le aziende dovranno padroneggiare

- 16 suggerimenti interessanti per trasformare i big data in grandi successi