Come installare Hive?

Apache Hadoop è una raccolta del framework che consente l'elaborazione di big data distribuiti in tutto il cluster. Secondo Apache Hive è un progetto software di data warehouse basato su Apache Hadoop per fornire query e analisi dei dati. Apache hive fornisce un'interfaccia simile a SQL per eseguire query ed elaborare una grande quantità di dati chiamati HQL (linguaggio di query Hive). L'hive di Apache funziona in cima all'ecosistema Hadoop e i dati memorizzati sotto forma di file indicano il file system distribuito di Hadoop (HDFS). Apache Hive fornisce all'utente un'ottima interfaccia per accedere ed eseguire un'operazione sui dati sotto forma di tabella, fornendo un'ottima tecnica di ottimizzazione per migliorare le prestazioni. È molto difficile rendere la query più veloce con i big data e credetemi, è importante in un ambiente di produzione.

Nel back-end, il compilatore converte la query HQL in mappa riduce i lavori e quindi viene inviato al framework Hadoop per le esecuzioni.

Differenza tra Hive e SQL

Apache Hive è molto simile a SQL ma, come sappiamo, l'hive viene eseguito sull'ecosistema Hadoop e converte internamente i lavori in MR (Map Reduce jobs), fa una differenza tra Hive e SQL.

Hive non sarebbe l'approccio migliore per quelle applicazioni in cui è richiesta una risposta molto rapida ed è molto importante capire che Hive è più adatto per l'elaborazione batch su set molto grandi di dati immutabili e dovremmo notare che Hive è un RDBMS normale e in ultimo ma non ultimo apache hive è lo schema sui mezzi di lettura (durante l'inserimento dei dati nella tabella degli alveari non si preoccuperà della mancata corrispondenza del tipo di dati ma durante la lettura dei dati mostrerà un valore nullo se il tipo di dati non corrisponde al tipo di dati della colonna specifica).

Requisito preliminare per l'installazione di Hive

Come ho detto prima, è molto importante capire che l'hive di Apache funziona su Hadoop Ecosystem e Hadoop dovrebbe essere attivo e funzionante con tutti i demoni.

Alcuni dei demoni Hadoop di base sono i seguenti:

- Nome nodo

- Nodo dati

- Responsabile delle risorse

- Gestione nodi

Per controllare la versione di Hadoop di seguito è il comando:

Digita → Versione di Hadoop nel prompt dei comandi che ti darà la versione di Hadoop.

Per controllare il comando di attivazione del report del cluster Hadoop sotto:

Digita → Hadoop dfsadmin –report nel prompt dei comandi ti darà l'intero report del cluster se il tuo server è in esecuzione.

Se Hadoop non è installato sul tuo computer e ti richiede di seguire le istruzioni apache per installare Hadoop sul tuo sistema.

Spero che Java sia già stato installato anche sul tuo sistema. per controllare la versione java, fare riferimento allo screenshot seguente.

Passaggi per installare Hive su Ubuntu

Di seguito sono riportati i passaggi per installare Hive su Ubuntu:

Step 1 : Hive tar che possiamo scaricare usando il comando seguente nel terminale che possiamo scaricare direttamente anche dal terminale.

Comando: otteniamo http://archive.apache.org/dist/hive/hive-2.1.0/apache-hive-2.1.0-bin.tar.gz

Fase 2 : Estrarre il file tar utilizzando il comando seguente nel terminale, è possibile estrarre direttamente il tar sopra il file tar tar hive scaricato.

Comando: tar -xzf apache-hive-2.1.0-bin.tar.gz

Ti suggerirò di verificare con il comando ls il file hive estratto.

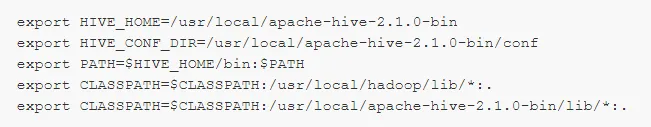

Passaggio 3: modificare il file " .bashrc " per aggiornare le variabili di ambiente per l'utente.

Comando: sudo il .bashrc

Aggiungi quanto segue alla fine del file:

# Imposta HIVE_HOME

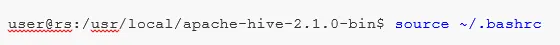

Eseguire il comando indicato di seguito per completare il lavoro di modifica nel terminale corrente.

Comando: sorgente .bashrc

Passaggio 5 : Dobbiamo creare le directory Hive all'interno della posizione HDFS e questa directory 'magazzino' sarà la posizione in cui archiviare le informazioni relative ai metadati della tabella degli alveari e i dati relativi a Hive.

Comando :

- hdfs dfs -mkdir -p / user / hive / warehouse

- hdfs dfs -mkdir / tmp

Passaggio 6 : Per impostare l'autorizzazione di lettura e scrittura per la tabella hive, eseguire il comando seguente.

Comando:

Nel comando seguente, fornendo l'autorizzazione di scrittura al gruppo di utenti:

- hdfs dfs -chmod g + w / user / hive / warehouse

- hdfs dfs -chmod g + w / tmp

Configurazione di Hive: è molto importante scegliere hive di punto di installazione da configurare con Hadoop. Dobbiamo modificare hive-env.sh, un file che si trova nella directory $ HIVE_HOME / conf. I seguenti comandi reindirizzano alla cartella conf Hive e copiano il file modello:

Passaggio 7 : Imposta un percorso Hadoop in hive-env.sh

Modifica il file hive-env.sh aggiungendo la seguente riga:

Ora, con questo processo, abbiamo quasi finito e le installazioni di hive sono state completate con successo, è importante configurare Metastore con il server di database esterno e, per impostazione predefinita, il framework Apache Hive utilizza il database Derby. Utilizzando il comando seguente Inizializzazione del database Derby.

Comando: bin / schematool -initSchema -dbType derby

Passaggio 8 : avviare Hive .

Comando: hive (digitare hive nel terminale all'interno del secondo terminale hive si aprirà.)

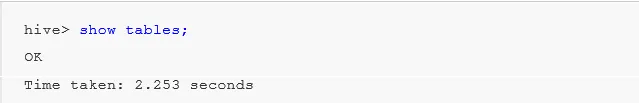

Lavorare con Hive: ora vedremo alcune delle operazioni nell'hive per vedere quante tabelle abbiamo nel database predefinito, fare riferimento alle schermate di seguito nelle schermate sottostanti non mostra alcuna tabella significa che non abbiamo alcuna tabella nel database predefinito .

Per creare una tabella nell'alveare è molto importante fare riferimento al database richiesto, altrimenti qualsiasi tabella verrà creata nel database predefinito.

Comandi importanti in Hive

1: mostra database (mostrerà tutti i database che sono stati ancora creati).

2: crea il database se non esiste mydb (questo comando creerà un database con il nome di " mydb" se " mydb" non esiste e se " mydb esiste già non verrà visualizzato alcun errore")

3: usa il database ogni volta che dobbiamo usare qualche comando DDl su quel particolare database dovremmo usare il comando “usa database” nel nostro caso abbiamo già creato il comando show “mydb” verrebbe usato mydb.

Importante comando DDL Hive

CREA, GOCCIA, TRASFORMA, MOSTRA, DESCRIVI .

- Crea : - Crea un'istruzione utilizzata per creare un database o creare una tabella in hive.

Esempio: hive> crea database company; (creazione del database)

Hive> usa la compagnia;

Hive> crea tabella dipendente (id int, nome String, stipendio String); (questo creerà un impiegato di tabella nella società di database perché abbiamo già eseguito il comando Usa database.)

- Descrivi fornisce informazioni sullo schema della tabella.

Alveare> descrivere dipendente; (questo fornirà i dettagli dello schema della tabella dei dipendenti in dettaglio)

- TRUNCATE eliminerà i dati della tabella.

Alveare> tronca l'impiegato della tabella;

Possiamo installare Hive anche su una finestra, ma per la migliore pratica, preferirò Ubuntu da utilizzare, offrirà una visione migliore dell'ambiente di produzione e i tuoi dati aumenteranno in futuro, sarà facile da gestire.

Articoli consigliati

Questa è stata una guida per installare Hive. Qui abbiamo discusso i diversi passaggi per installare Hive, il comando DDL ecc. Puoi anche leggere i seguenti articoli per saperne di più:

- Come installare SQL Server

- Come installare MATLAB

- Comandi e funzionalità dell'alveare

- Domande di base per l'intervista all'alveare

- Hive Architecture | WorkFlow

- Utilizzo della funzione ORDER BY in Hive

- Installazione alveare