Panoramica di Data Lake

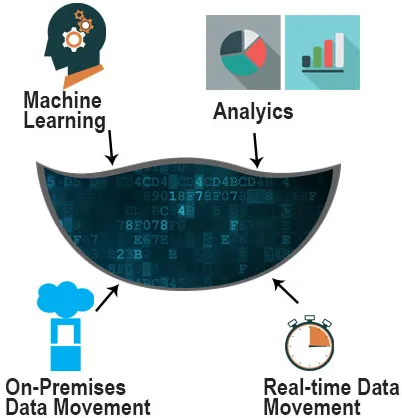

Un data lake è un repository in cui è possibile archiviare una grande quantità di dati semi-strutturati, strutturati e non strutturati. Un ID univoco con un set di tag di metadati estesi viene assegnato a tutti gli elementi di dati di un data lake. Quando sorge una domanda aziendale, è possibile richiedere i dati rilevanti e quindi analizzare i dati più piccoli per rispondere alla domanda. Il lago ha un'architettura piatta, al contrario di un data warehouse gerarchico in cui i dati sono archiviati in file e cartelle. Senza la prima strutturazione dei dati, è possibile archiviare le informazioni così come sono e possiamo eseguire vari tipi di analisi come dashboard e visualizzazioni in una grande elaborazione dei dati, analisi in tempo reale e machine learning per informare le decisioni migliori.

Un lago viene utilizzato da professionisti come data scientist, sviluppatori di dati e analisti aziendali per archiviare una grande quantità di dati.

Utilizzato in un lago è non relazionale e relazionale da dispositivi IoT, siti Web, applicazioni mobili, ecc. Nello schema, è scritto al momento dell'analisi, cioè schema sulla lettura. Il risultato dopo l'esecuzione della query è più veloce.

Perché abbiamo bisogno di un Data Lake?

Costruendo un lago, i data scientist possono vedere la vista non raffinata dei dati.

I motivi per usarlo sono i seguenti:

La società che produce vantaggi commerciali dai propri dati supera con successo i propri colleghi. In un sondaggio di Aberdeen, la società che ha istituito un Data Lake è stata del 9% superiore alla performance di crescita del fatturato organico di società simili. Questi leader sono stati in grado di eseguire nuovi tipi di analisi come l'apprendimento automatico attraverso nuove fonti come file di registro, dati clickstream, social media e connettività Internet nel lago.

Supporta l'importazione di dati che arrivano in tempo reale. I dati vengono raccolti da più risorse e quindi spostati nel lago nel formato originale. Un lago offre una maggiore scalabilità dei dati. Inoltre, puoi sapere quale tipo di dati si trova nel lago indicizzando, eseguendo la scansione, catalogando i dati.

Supporta la governance dei dati che gestisce la disponibilità, l'usabilità, la sicurezza e l'integrità dei dati.

Può aiutare i team di ricerca e sviluppo a testare le loro ipotesi, affinare le ipotesi e valutare i risultati.

Nessuna struttura del silo è disponibile.

Offre ai clienti una visione a 360 gradi e un'analisi solida.

La qualità dell'analisi aumenta anche con l'aumento del volume dei dati, della qualità dei dati e dei metadati.

- I motori di archiviazione come Hadoop hanno reso semplice la memorizzazione di informazioni disparate. Non è necessario modellare i dati con un lago in uno schema a livello aziendale.

- La qualità delle analisi aumenta anche con l'aumento del volume dei dati, della qualità dei dati e dei metadati.

- Offre agilità aziendale

- È possibile utilizzare l'apprendimento automatico e l'intelligenza artificiale per fare previsioni redditizie.

Architettura di Data Lake su Hadoop, AWS e Azure

Un lago di dati ha due componenti: archiviazione e calcolo. Archiviazione e elaborazione possono essere localizzate sul posto o nel cloud. Ciò comporta la progettazione di un'architettura di data lake in più possibili combinazioni.

1. Hadoop

Un cluster Hadoop di server distribuito risolve i problemi di archiviazione dei big data. MapReduce è il modello di programmazione Hadoop utilizzato per dividere ed elaborare le informazioni in sottoinsiemi più piccoli nel cluster di server.

2. AWS

La gamma di prodotti AWS per la sua soluzione data lake è completa. Amazon S3 è al centro della soluzione per le funzioni di archiviazione. Questi strumenti di inserimento dati che ci consentono di trasferire enormi quantità di dati in S3 sono Kinesis Stream, Kinesis Firehose, Snowball e Direct Connect.

Oltre ad Amazon S3, il database NoSQL, Dynamo DB e Elastic Search offrono un processo di query semplificato. AWS offre una vasta gamma di prodotti con una curva di apprendimento iniziale ripida. Tuttavia, le funzionalità complete della soluzione sono ampiamente utilizzate nelle applicazioni di intelligence commerciale.

3. Azure

Micro-soft ha offerto il data lake. Il data lake di Azure ha un livello di analisi e archiviazione chiamato Azure Store (ADLS) e i due componenti che il livello analitico ha Azure Analytics e HDInsight. Lo standard ADLS è stato creato in HDFS e sono in grado di archiviare senza limiti. Può salvare trilioni di file di dimensioni superiori a un petabyte in un unico file. Azure Store consente di archiviare, proteggere e scalare i dati in qualsiasi formato.

Benefici

Di seguito sono riportati alcuni punti importanti

- Fornisce un valore illimitato per il tipo di dati

- Adattabile ai cambiamenti rapidamente

- I costi di proprietà a lungo termine sono ridotti

- Il suo principale vantaggio è la centralizzazione di varie fonti di contenuto

- Gli utenti di diversi dipartimenti in tutto il mondo possono avere un accesso flessibile ai dati

- Fornisce scalabilità e flessibilità economiche

Rischio

- Potrebbe perdere rilevanza e slancio dopo qualche tempo.

- Vi è un rischio maggiore durante la progettazione

- Aumenta anche il costo di archiviazione e prodotti

- La sicurezza e il controllo degli accessi rappresentano il rischio maggiore. A volte i dati possono essere collocati in un lago senza supervisione, poiché alcuni dei dati potrebbero dover essere protetti e regolamentati.

Articoli consigliati

Questa è stata una guida a What is a Data Lake ?. Qui abbiamo discusso il concetto, perché abbiamo bisogno di Data Lake insieme ai loro vantaggi e rischi. Puoi anche consultare i nostri altri articoli consigliati per saperne di più-

- Integrazione moderna dei dati

- Che cos'è Data Analytics

- Che cos'è la violazione dei dati?

- Data Scientist vs Big Data

- Data Lake vs Data Warehouse | differenze