Che cos'è la tecnologia dei Big Data?

Come sappiamo, i dati sono in continua evoluzione. La crescita dei dati ha sfidato le menti umane a estrarre, analizzare e gestirle. Questo perché i modi tradizionali di trattare i dati non riescono a supportare questi big data. I big data sono di solito descritti da tre concetti: volume, varietà e velocità.

I dati sono ora diventati la risorsa più importante di ogni azienda. Analizzare questi big data aiuta l'azienda ad analizzare il comportamento dei propri clienti e prevedere le cose rilevanti associate a quelle decisioni basate sui dati che rendono l'organizzazione, prendono mosse più sicure e costruiscono strategie più forti.

Conoscendo il ritmo con cui i dati stanno aumentando nell'era di oggi, i big data saranno un campo gigante nel prossimo futuro per cui lavorare. Tutti gli studenti, i professionisti del settore, i professionisti saranno necessari per tenersi aggiornati con le tecnologie emergenti dei big data. Tenersi aggiornati porterà una carriera grandiosa e di successo nel proprio percorso professionale.

Tecnologie per i Big Data

Qui sto elencando alcune tecnologie di big data con una spiegazione lucida su di esso, per farti conoscere le tendenze e la tecnologia imminenti:

-

Apache Spark:

È un veloce motore di elaborazione dei big data. Questo è stato creato tenendo presente l'elaborazione in tempo reale dei dati. La sua ricca libreria di Machine learning è utile per lavorare nello spazio di AI e ML. Elabora i dati in parallelo e su computer cluster. Il tipo di dati di base utilizzato da Spark è RDD (set di dati distribuiti resilienti).

-

Database NoSQL:

Si tratta di database non relazionali che forniscono archiviazione e recupero rapidi dei dati. La sua capacità di trattare tutti i tipi di dati come dati strutturati, semi-strutturati, non strutturati e polimorfici rende unica. Nessun database SQL è dei seguenti tipi:

- Database di documenti : memorizza i dati sotto forma di documenti che possono contenere diverse coppie chiave-valore.

- Archivi grafici : memorizza i dati che di solito vengono archiviati sotto forma di rete come i dati dei social media.

- Archivi di valori-chiave : sono i database NoSQL più semplici. Ogni singolo elemento nel database viene archiviato come nome di attributo (o "chiave"), insieme al suo valore.

- Archivi a colonne larghe : questo database archivia i dati nel formato colonnare anziché nel formato basato su righe. Cassandra e HBase ne sono un buon esempio.

-

Apache Kafka:

Kafka è una piattaforma di streaming di eventi distribuiti che gestisce molti eventi ogni giorno. Essendo veloce e scalabile, questo è utile nella creazione di pipeline di dati in streaming in tempo reale che raccolgono in modo affidabile dati tra sistemi o applicazioni.

-

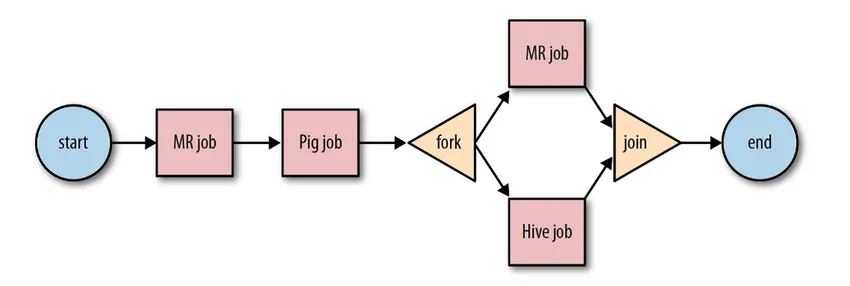

Apache Oozie:

È un sistema di pianificazione del flusso di lavoro per gestire i lavori Hadoop. Questi lavori del flusso di lavoro sono programmati sotto forma di Directed Acyclical Graphs (DAG) per le azioni.

Fonte: Google

La sua soluzione scalabile e organizzata per le attività di big data.

-

Apache Airflow:

Questa è una piattaforma che pianifica e monitora il flusso di lavoro. La pianificazione intelligente aiuta a organizzare in modo efficiente l'esecuzione del progetto. Airflow possiede la capacità di rieseguire un'istanza DAG in caso di errore. La sua ricca interfaccia utente semplifica la visualizzazione di condutture in esecuzione in varie fasi come produzione, monitoraggio dei progressi e risoluzione dei problemi quando necessario.

-

Apache Beam:

È un modello unificato, per definire ed eseguire pipeline di elaborazione dati che includono ETL e streaming continuo. Il framework Apache Beam fornisce un'astrazione tra la logica dell'applicazione e l'ecosistema dei big data, in quanto non esiste alcuna API che leghi tutti i framework come Hadoop, spark, ecc.

-

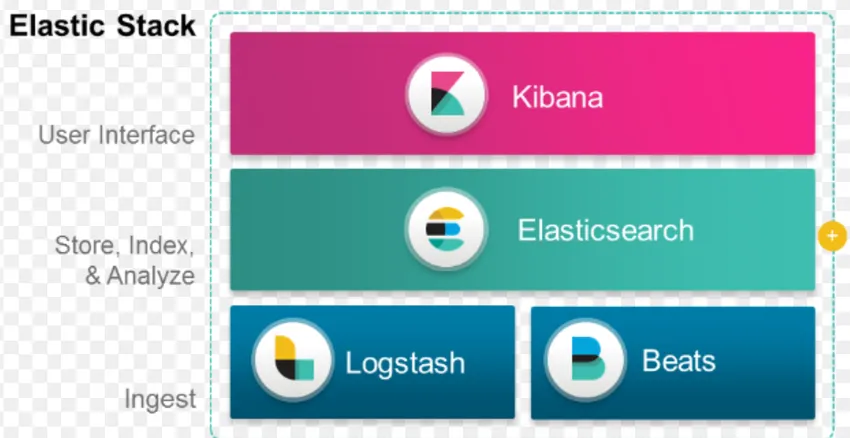

Stack ELK:

ELK è noto per Elasticsearch, Logstash e Kibana.

Elasticsearch è un database senza schemi (che indicizza ogni singolo campo) che ha potenti capacità di ricerca e facilmente scalabili.

Logstash è uno strumento ETL che ci consente di recuperare, trasformare e archiviare eventi in Elasticsearch.

Kibana è uno strumento di dashboard per Elasticsearch, in cui è possibile analizzare tutti i dati memorizzati. Le intuizioni fruibili estratte da Kibana aiutano a costruire strategie per un'organizzazione. Dall'acquisizione delle modifiche alla previsione, Kibana si è sempre dimostrata molto utile.

-

Docker & Kubernete:

Queste sono le tecnologie emergenti che aiutano le applicazioni a funzionare in container Linux. Docker è una raccolta open source di strumenti che ti aiutano a "costruire, spedire ed eseguire qualsiasi app, ovunque".

Kubernetes è anche una piattaforma di container / orchestrazione open source, che consente a un gran numero di container di lavorare insieme in armonia. Ciò alla fine riduce l'onere operativo.

-

tensorflow:

È una libreria di apprendimento automatico open source che viene utilizzata per progettare, costruire e formare modelli di apprendimento profondo. Tutti i calcoli vengono eseguiti in TensorFlow con grafici del flusso di dati. I grafici comprendono nodi e bordi. I nodi rappresentano operazioni matematiche, mentre i bordi rappresentano i dati.

TensorFlow è utile per la ricerca e la produzione. È stato creato tenendo presente che potrebbe funzionare su più CPU o GPU e persino sistemi operativi mobili. Questo potrebbe essere implementato in Python, C ++, R e Java.

-

Presto:

Presto è un motore SQL open source sviluppato da Facebook, in grado di gestire petabyte di dati. A differenza di Hive, Presto non dipende dalla tecnica MapReduce e quindi più veloce nel recupero dei dati. La sua architettura e interfaccia sono abbastanza facili da interagire con altri file system.

A causa della bassa latenza e della semplice query interattiva, oggigiorno sta diventando molto popolare per la gestione dei big data.

-

Polybase:

Polybase funziona su SQL Server per accedere ai dati archiviati in PDW (Parallel Data Warehouse). PDW creato per l'elaborazione di qualsiasi volume di dati relazionali e fornisce l'integrazione con Hadoop.

-

Alveare:

Hive è una piattaforma utilizzata per la query e l'analisi dei dati su set di dati di grandi dimensioni. Fornisce un linguaggio di query simile a SQL chiamato HiveQL, che internamente viene convertito in MapReduce e quindi viene elaborato.

Con la rapida crescita dei dati e l'enorme impegno dell'organizzazione per l'analisi dei big data, la tecnologia ha portato sul mercato così tante tecnologie maturate che conoscerle è di enorme beneficio. Al giorno d'oggi, la tecnologia dei big data affronta molte esigenze e problemi aziendali, aumentando l'efficienza operativa e prevedendo il comportamento rilevante. Una carriera nei big data e nella relativa tecnologia può aprire molte porte di opportunità sia per la persona che per le aziende.

D'ora in poi, è giunto il momento di adottare tecnologie per i big data.

Articoli consigliati

Questa è stata una guida a What is Big Data Technology. Qui abbiamo discusso alcune tecnologie di big data come Hive, Apache Kafka, Apache Beam, ELK Stack, ecc. Puoi anche leggere il seguente articolo per saperne di più -

- Che cos'è l'apprendimento profondo?

- Guida a Minitab?

- Cos'è la tecnologia Salesforce?

- Che cos'è l'analisi dei big data?