Panoramica di Installa Hadoop

L'articolo seguente, Installa Hadoop fornisce una descrizione dei moduli chiave del framework Hadoop più comuni e un'installazione graduale per Hadoop. Apache Hadoop è una raccolta di software che consente l'elaborazione di set di dati di grandi dimensioni e archiviazione distribuita su un cluster di diversi tipi di sistema informatico. Attualmente, Hadoop rimane la piattaforma di analisi più utilizzata per i big data ("Sanchita Lobo, autore di Analytics Training Blog", nd).

Quadro Hadoop

Il framework Apache Hadoop è costituito dai seguenti moduli chiave.

- Apache Hadoop Common.

- Apache Hadoop Distributed File System (HDFS).

- Apache Hadoop MapReduce

- Apache Hadoop YARN (Yet Another Resource Manager).

Apache Hadoop Common

Il modulo Apache Hadoop Common è costituito da librerie condivise che vengono utilizzate in tutti gli altri moduli, tra cui gestione delle chiavi, pacchetti I / O generici, librerie per la raccolta delle metriche e utilità per il registro, la sicurezza e lo streaming.

HDFS

L'HDFS si basa sul file system di Google ed è strutturato per funzionare su hardware a basso costo. HDFS è tollerante agli errori ed è progettato per applicazioni con set di dati di grandi dimensioni.

Riduci mappa

MapReduce è un modello di programmazione parallela inerente per l'elaborazione dei dati e Hadoop può eseguire programmi MapReduce scritti in varie lingue come Java. MapReduce funziona suddividendo l'elaborazione nella fase della mappa e riduce la fase.

Apache Hadoop YARN

Apache Hadoop YARN è un componente principale ed è la tecnologia di gestione delle risorse e pianificazione dei lavori nel framework di elaborazione distribuito di Hadoop.

In questo articolo, discuteremo l'installazione e la configurazione di Hadoop 2.7.4 su un cluster a nodo singolo e testeremo la configurazione eseguendo il programma MapReduce chiamato wordcount per contare il numero di parole nel file. Esamineremo ulteriormente alcuni importanti comandi del file system Hadoop.

Passaggi per installare Hadoop

Di seguito è riportato un riepilogo delle attività coinvolte nella configurazione di Apache Hadoop.

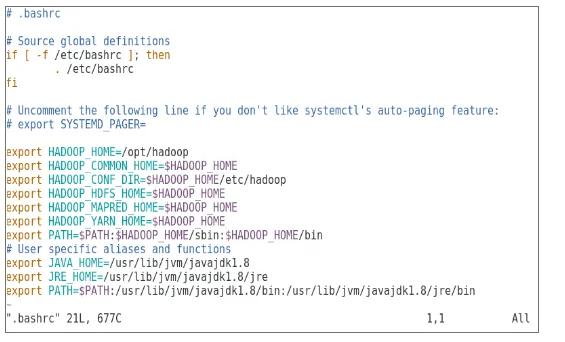

Attività 1: la prima attività dell'installazione di Hadoop includeva la configurazione di un modello di macchina virtuale configurato con Cent OS7. Pacchetti come Java SDK 1.8 e Runtime Systems richiesti per eseguire Hadoop sono stati scaricati e la variabile di ambiente Java per Hadoop è stata configurata modificando bash_rc.

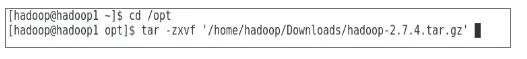

Attività 2: il pacchetto Hadoop versione 2.7.4 è stato scaricato dal sito Web apache ed è stato estratto nella cartella opt. Che è stato poi ribattezzato Hadoop per un facile accesso.

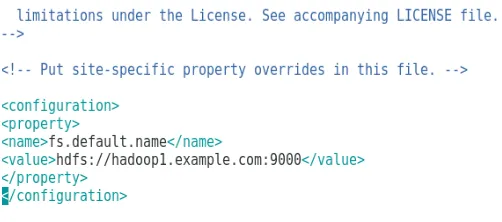

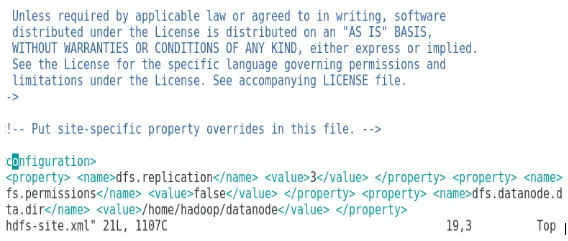

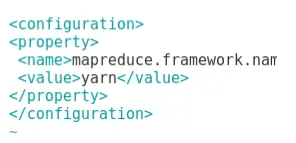

Attività 3: Una volta estratti i pacchetti Hadoop, il passaggio successivo includeva la configurazione della variabile di ambiente per l'utente Hadoop seguita dalla configurazione dei file XML del nodo Hadoop. In questo passaggio, NameNode è stato configurato in core-site.xml e DataNode è stato configurato in hdfs-site.xml. Il gestore risorse e il gestore nodo sono stati configurati in thread-site.xml.

Attività 4: il firewall è stato disabilitato per avviare YARN e DFS. Il comando JPS è stato utilizzato per verificare se i daemon rilevanti sono in esecuzione in background. Il numero di porta per accedere a Hadoop è stato configurato su http: // localhost: 50070 /

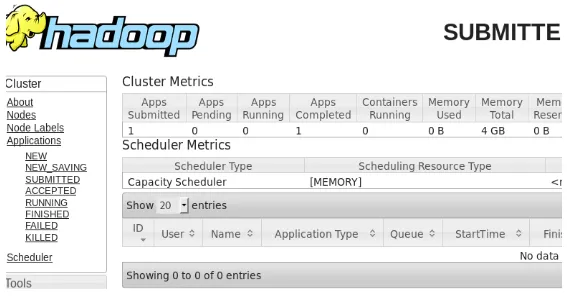

Attività 5: I seguenti passaggi sono stati utilizzati per verificare e testare Hadoop. Per questo, abbiamo creato un file di prova temporaneo nella directory di input per il programma WordCount. Il programma di riduzione delle mappe Hadoop-MapReduce-samples2.7.4.jar è stato usato per contare il numero di parole nel file. I risultati sono stati valutati sull'host locale e sono stati analizzati i registri dell'applicazione presentata. Tutte le applicazioni MapReduce inviate possono essere visualizzate sull'interfaccia online, il numero di porta predefinito è 8088.

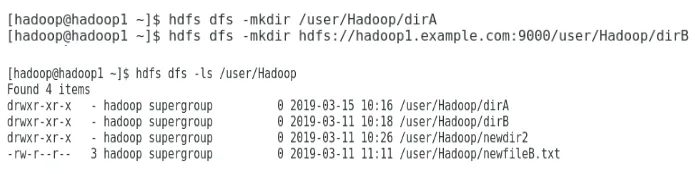

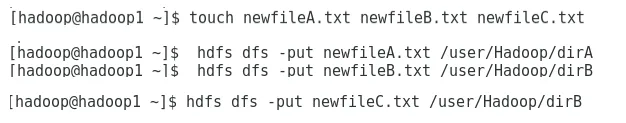

Attività 6: Nell'attività finale, introdurremo alcuni comandi di base del file system Hadoop e ne controlleremo l'utilizzo. Vedremo come è possibile creare una directory all'interno del file system Hadoop, per elencare il contenuto di una directory, la sua dimensione in byte. Vedremo inoltre come eliminare una directory e un file specifici.

Risultati nell'installazione di Hadoop

Quanto segue mostra i risultati di ciascuna delle attività sopra elencate:

Risultato dell'attività 1

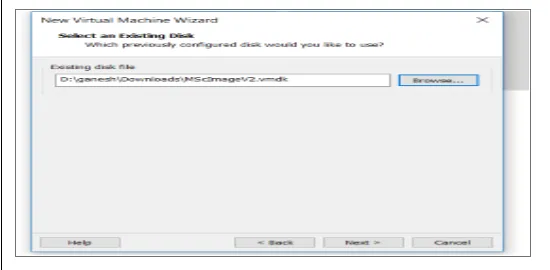

Una nuova macchina virtuale con un'immagine cenOS7 è stata configurata per eseguire Apache Hadoop. La Figura 1 mostra come l'immagine CenOS 7 è stata configurata nella macchina virtuale. La Figura 1.2 mostra la configurazione della variabile d'ambiente JAVA all'interno di .bash_rc.

Figura 1: configurazione della macchina virtuale

Figura 1.2: Configurazione delle variabili di ambiente Java

Risultato dell'attività 2

La Figura 2 mostra l'attività svolta per estrarre il pacchetto Hadoop 2.7.4 nella cartella opt.

Figura 2: Estrazione del pacchetto Hadoop 2.7.4

Risultato dell'attività 3

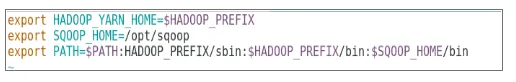

La Figura 3 mostra la configurazione per la variabile d'ambiente per l'utente Hadoop, le Figure da 3.1 a 3.4 mostrano la configurazione per i file XML richiesti per la configurazione di Hadoop.

Figura 3: configurazione della variabile d'ambiente per l'utente Hadoop

Figura 3.1: Configurazione di core-site.xml

Figura 3.2: Configurazione di hdfs-site.xml

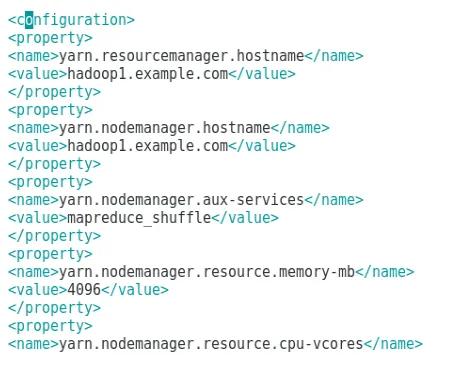

Figura 3.3: Configurazione del file mapred-site.xml

Figura 3.4: Configurazione del file yarn-site.xml

Risultato dell'attività 4

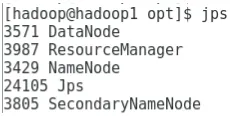

La Figura 4 mostra l'uso del comando jps per verificare che i demoni rilevanti siano in esecuzione in background e la figura seguente mostra l'interfaccia utente online di Hadoop.

Figura 4: comando jps per verificare l'esecuzione dei daemon.

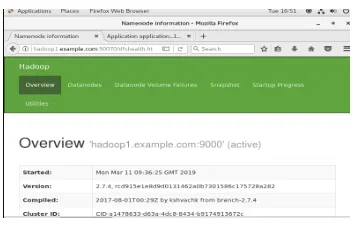

Figura 4.1: Accesso all'interfaccia online di Hadoop sulla porta http://hadoop1.example.com:50070/

Risultato dell'attività 5

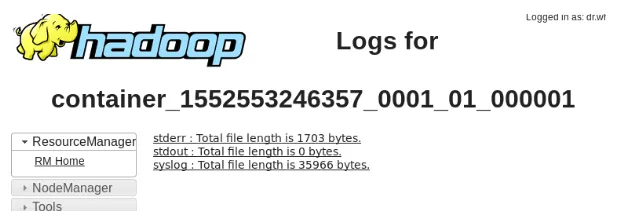

La Figura 5 mostra il risultato per il programma MapReduce chiamato wordcount che conta il numero di parole nel file. La prossima coppia di figure mostra l'interfaccia utente online del gestore risorse YARN per l'attività inviata.

Figura 5: risultati del programma MapReduce

Figura 5.1: Applicazione di riduzione della mappa inviata.

Figura 5.2: Registri per l'applicazione MapReduce inviata.

Risultato dell'attività 6

La Figura 6 mostra come creare una directory all'interno del file system Hadoop ed eseguire un elenco della directory hdfs.

Figura 6: creazione di una directory all'interno del file system Hadoop

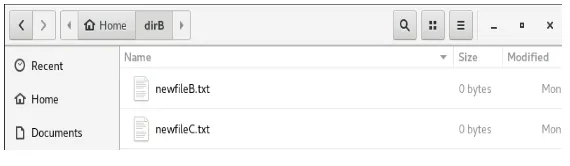

La Figura 6.1 mostra come inserire un file nel file system distribuito di Hadoop e la Figura 6.2 mostra il file creato nella directory dirB.

Figura 6.1: Creazione di un file in HDFS.

Figura 6.2: Nuovo file creato.

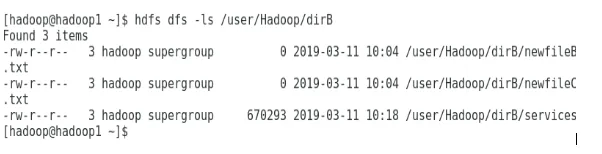

Le prossime figure mostrano come elencare i contenuti di particolari directory:

Figura 6.3: Contenuto di dirA

Figura 6.4: Contenuto di dirB

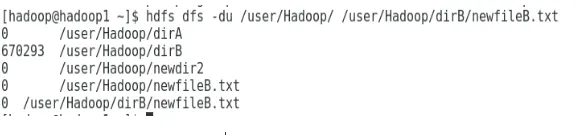

La figura seguente mostra come possono essere visualizzate le dimensioni di file e directory:

Figura 6.5: visualizzare le dimensioni di un file e di una directory.

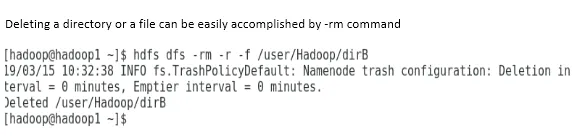

L'eliminazione di una directory o di un file può essere facilmente eseguita dal comando -rm.

Figura 6.6: per eliminare un file.

Conclusione

I Big Data hanno svolto un ruolo molto importante nel plasmare il mercato mondiale di oggi. Il framework Hadoop semplifica la vita dell'analista di dati mentre si lavora su set di dati di grandi dimensioni. La configurazione di Apache Hadoop era piuttosto semplice e l'interfaccia utente online forniva all'utente diverse opzioni per ottimizzare e gestire l'applicazione. Hadoop è stato utilizzato in modo massiccio nelle organizzazioni per l'archiviazione dei dati, l'analisi dell'apprendimento automatico e il backup dei dati. La gestione di una grande quantità di dati è stata molto utile grazie all'ambiente distribuito Hadoop e MapReduce. Lo sviluppo di Hadoop è stato piuttosto sorprendente rispetto ai database relazionali in quanto privi di opzioni di ottimizzazione e prestazioni. Apache Hadoop è una soluzione intuitiva ea basso costo per la gestione e l'archiviazione di big data in modo efficiente. HDFS fa anche molto per aiutare nella memorizzazione dei dati.

Articoli consigliati

Questa è una guida per installare Hadoop. Qui discutiamo dell'introduzione a Instal Hadoop, installazione passo passo di Hadoop insieme ai risultati dell'installazione di Hadoop. Puoi anche consultare i nostri altri articoli suggeriti per saperne di più -

- Introduzione allo streaming di Hadoop

- Che cos'è Hadoop Cluster e come funziona?

- Apache Hadoop Ecosystem e suoi componenti

- Quali sono le alternative Hadoop?