Introduzione all'architettura dei Big Data

Quando si tratta di gestire dati pesanti e fare operazioni complesse su quei dati enormi, diventa necessario utilizzare strumenti e tecniche per i big data. Quando diciamo che utilizzando strumenti e tecniche per i big data intendiamo effettivamente che stiamo chiedendo di utilizzare vari software e procedure che si trovano nell'ecosistema dei big data e nella sua sfera. Non esiste una soluzione generica che viene fornita per ogni caso d'uso e quindi deve essere realizzata e realizzata in modo efficace secondo i requisiti aziendali di una determinata azienda. Pertanto, diventa necessario ricorrere a diverse architetture di big data poiché la combinazione di varie tecnologie comporterà il conseguimento del caso d'uso risultante. Stabilendo un'architettura fissa, è possibile garantire che sia fornita una soluzione praticabile per il caso d'uso richiesto.

Che cos'è l'architettura dei Big Data?

- Questa architettura è progettata in modo tale da gestire il processo di importazione, l'elaborazione dei dati e l'analisi dei dati è troppo grande o complessa per gestire i tradizionali sistemi di gestione del database.

- Organizzazioni diverse hanno soglie diverse per le loro organizzazioni, alcune ce l'hanno per poche centinaia di gigabyte, mentre per altre anche alcuni terabyte non sono abbastanza validi come valore soglia.

- A causa di questo evento che si verifica se si osservano i sistemi di merci e lo stoccaggio delle merci, i valori e il costo dello stoccaggio sono notevolmente ridotti. Esiste un'enorme varietà di dati che richiedono diversi modi per essere soddisfatti.

- Alcuni di essi sono dati relativi ai batch che arrivano in un determinato momento e quindi i lavori devono essere pianificati in modo simile mentre altri appartengono alla classe di streaming in cui deve essere costruita una pipeline di streaming in tempo reale per soddisfare tutte le requisiti. Tutte queste sfide sono risolte dall'architettura dei big data.

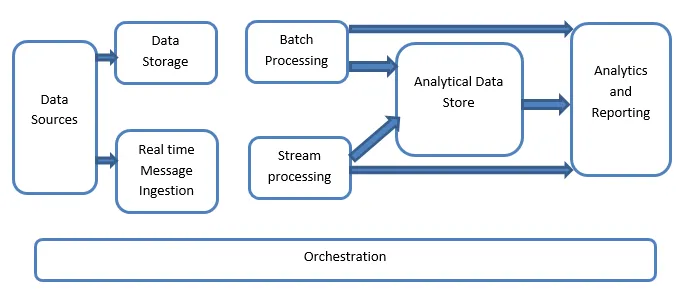

Spiegazione dell'architettura dei Big Data:

I sistemi di Big Data coinvolgono più di un tipo di carico di lavoro e sono ampiamente classificati come segue:

- Laddove le grandi fonti basate su dati sono a riposo, è coinvolta l'elaborazione in batch.

- Elaborazione di big data in movimento per l'elaborazione in tempo reale.

- Esplorazione di strumenti e tecnologie interattivi per big data.

- Apprendimento automatico e analisi predittiva.

1. Fonti di dati

Le fonti di dati coinvolgono tutte quelle fonti d'oro da cui viene costruita la pipeline di estrazione dei dati e quindi si può dire che questo sia il punto di partenza della pipeline di big data.

Gli esempi includono:

(i) Datastore di applicazioni come quelle come database relazionali

(ii) I file che sono prodotti da una serie di applicazioni e sono principalmente una parte di file system statici come file server basati su web che generano log.

(iii) dispositivi IoT e altre fonti di dati in tempo reale.

2. Archiviazione dei dati

Ciò include i dati che sono gestiti per le operazioni di generazione in batch e sono archiviati negli archivi di file che sono distribuiti in natura e sono anche in grado di contenere grandi volumi di file di grandi dimensioni supportati da formati diversi. Si chiama data lake. Questo in genere costituisce la parte in cui vengono forniti gli archivi Hadoop come HDFS, Microsoft Azure, AWS, GCP insieme ai contenitori BLOB.

3. Elaborazione batch

Tutti i dati sono separati in diverse categorie o blocchi che fanno uso di processi di lunga durata utilizzati per filtrare e aggregare e anche preparare i dati o lo stato elaborato per l'analisi. Questi lavori di solito fanno uso di fonti, li elaborano e forniscono l'output dei file elaborati ai nuovi file. L'elaborazione batch viene eseguita in vari modi facendo uso di lavori Hive o lavori basati su U-SQL o facendo uso di Sqoop o Pig insieme ai lavori personalizzati di riduzione delle mappe che sono generalmente scritti in uno qualsiasi di Java o Scala o in qualsiasi altro linguaggio come Python.

4. Ingestione di messaggi in tempo reale

Ciò include, a differenza dell'elaborazione batch, tutti quei sistemi di streaming in tempo reale che soddisfano i dati generati in sequenza e secondo uno schema fisso. Questo è spesso un semplice data mart o un archivio responsabile di tutti i messaggi in arrivo che vengono rilasciati all'interno della cartella necessariamente utilizzati per l'elaborazione dei dati. Esistono, tuttavia, la maggior parte delle soluzioni che richiedono la necessità di un archivio di importazione basato su messaggi che funge da buffer dei messaggi e supporta anche l'elaborazione basata su scala, fornisce una consegna relativamente affidabile insieme ad altre semantiche di accodamento della messaggistica. Le opzioni includono Apache Kafka, Apache Flume, Hub eventi di Azure, ecc.

5. Elaborazione in streaming

Esiste una leggera differenza tra l'immissione dei messaggi in tempo reale e l'elaborazione del flusso. Il primo prende in considerazione i dati ingeriti che vengono inizialmente raccolti e quindi utilizzati come tipo di sottoscrizione di pubblicazione di uno strumento. L'elaborazione del flusso, d'altra parte, viene utilizzata per gestire tutti quei dati di streaming che si verificano in Windows o stream e quindi li scrive nel sink di output. Questo include Apache Spark, Apache Flink, Storm, ecc.

6. Archivio dati basato su Analytics

Questo è l'archivio dati utilizzato a fini analitici e quindi i dati già elaborati vengono quindi interrogati e analizzati utilizzando strumenti di analisi che possono corrispondere alle soluzioni di BI. I dati possono anche essere presentati con l'aiuto di una tecnologia di data warehouse NoSQL come HBase o qualsiasi uso interattivo del database hive che può fornire l'astrazione dei metadati nell'archivio dati. Gli strumenti includono Hive, Spark SQL, Hbase, ecc.

7. Rapporti e analisi

Le intuizioni devono essere generate sui dati elaborati e ciò viene effettivamente svolto dagli strumenti di reporting e analisi che utilizzano la loro tecnologia e soluzione incorporate per generare grafici utili, analisi e approfondimenti utili per le aziende. Gli strumenti includono Cognos, Hyperion, ecc.

8. Orchestrazione

Le soluzioni basate su big data consistono in operazioni relative ai dati che sono di natura ripetitiva e sono anche incapsulate nei flussi di lavoro che possono trasformare i dati di origine e anche spostare i dati tra le fonti, nonché i lavandini e caricare nei negozi e spingere in unità analitiche. Esempi includono Sqoop, oozie, data factory, ecc.

Conclusione

In questo post, leggiamo l'architettura dei big data necessaria per implementare queste tecnologie nell'azienda o nell'organizzazione. Spero ti sia piaciuto il nostro articolo.

Articoli consigliati

Questa è stata una guida all'architettura dei Big Data. Qui discutiamo di cosa sono i big data? e abbiamo anche spiegato l'architettura dei big data insieme allo schema a blocchi. Puoi anche consultare i nostri altri articoli suggeriti per saperne di più -

- Tecnologie per i Big Data

- Big Data Analytics

- Carriere nei Big Data

- Domande sui colloqui sui Big Data

- I 8 principali dispositivi dell'IoT che dovresti sapere

- Tipi di join in Spark SQL (esempi)