Introduzione agli schedulatori Hadoop

Quando parliamo di Hadoop, la prima cosa che ci viene in mente sono i big data. Ma ci siamo mai chiesti che Hadoop in sé non è solo una tecnologia, ma racchiude al suo interno molti strumenti e tecniche, quindi come siamo esattamente in grado di raggiungere automaticamente ciò che si intende attraverso Hadoop. La risposta a questa domanda è utilizzando gli scheduler Hadoop.

Consente un elevato livello di elaborazione del sistema ed è anche noto come il sistema generico che agisce a livello di distribuzione di un insieme di dati e informazioni. È un sistema multitasking utilizzato per elaborare più set di dati per molti utenti e lavori contemporaneamente. In precedenza, per tutte le attività veniva utilizzato solo uno scheduler, ma ora gli scheduler Hadoop sono quelli utilizzati insieme alla logica JobTracker e sono supportati anche da Hadoop.

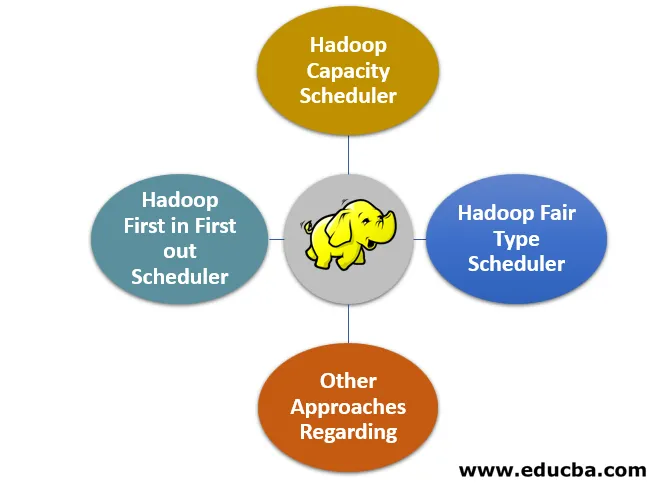

I 4 migliori tipi di programmatori Hadoop

Esistono diversi tipi di programmatori Hadoop che utilizziamo spesso:

1. Hadoop First in First out Scheduler

- Come suggerisce il nome, questo è uno di quei più antichi programmatori di lavoro che funziona secondo il principio del primo in entrata e del primo in uscita. Fondamentalmente, quando parliamo di un processo come quello di JobTracker, parliamo di estrarre i lavori dalla coda, che spesso viene definita la coda del lavoro.

- Secondo tale lavoro in coda, il lavoro che è il più vecchio, cioè quello che è stato il primo, sarà il primo ad essere eseguito per primo.

- Si è sempre ritenuto che questo fosse un approccio molto più semplice rispetto ad altre tecniche di pianificazione e quindi non si pensava molto a scartare questa tecnica solo per trovare approcci più recenti con migliori capacità di pianificazione in quanto includevano anche in se stessi concetti di dimensionamento e priorità del lavoro.

2. Hadoop Capacity Scheduler

- Lo scheduler di capacità Hadoop è più o meno simile all'approccio FIFO, tranne per il fatto che si avvale anche della priorità del lavoro. Questo approccio ha un approccio leggermente diverso quando parliamo del livello di pianificazione multiutente.

- Questo è noto per pianificare e simulare un cluster MapReduce separato per ogni organizzazione o utente e che viene eseguito insieme al tipo di pianificazione FIFO.

3. Hadoop Fair Type Scheduler

- Quando si presenta la necessità di fornire una quantità separata e ragionevole di capacità del cluster con tempo e periodo, ci avvaliamo del programmatore equo Hadoop. È utile per ottenere tutti i cluster anche se un determinato lavoro è in esecuzione.

- Inoltre, tutti gli slot liberi del cluster sono forniti a tutti i lavori in modo tale che ogni utente ottenga una quota normalizzata della parte del proprio cluster quando più lavori diventano utili da inviare.

- Se esiste un pool che non ha ancora ricevuto la sua parte della quota equa e una quota normalizzata per un periodo di tempo e un periodo ragionevolmente buoni, allora entra in gioco la preemption uccidendo così tutte le attività in pool e funzionando con la capacità di fornire quel pool slot per funzionare sotto capacità.

- Inoltre, questo è anche noto come il modulo contrib, il che significa che copiando la directory di controllo di Hadoop e basata su scheduler equi nella directory basata su lib e posizionando il file JAR nella posizione appropriata, è possibile abilitare questa tecnica di pianificazione. L'unica cosa che è necessario fare è impostare la proprietà dell'utilità di pianificazione su mapred.FairScheduler.

4. Altri approcci riguardanti lo Scheduler

- Hadoop garantisce di offrire una fornitura di cluster virtuali, il che significa che è possibile ridurre al minimo la necessità di disporre di cluster fisici reali e questa tecnica è nota come HOD (Hadoop on Demand).

- Utilizza il gestore delle risorse basato su Torque per mantenere i nodi attivi e la sua allocazione in base alle esigenze del cluster virtuale.

- Viene utilizzato per inizializzare il carico e il sistema che si basa su nodi particolari all'interno del cluster virtuale e non fisico e anche insieme ai nodi allocati, solo dopo che i file di configurazione sono stati preparati automaticamente.

- Il cluster HOD potrebbe anche essere usato in modo relativamente indipendente una volta avvenuta l'inizializzazione. In poche parole, un modello in poche parole che viene utilizzato per la distribuzione di questi grandi cluster Hadoop è all'interno dell'infrastruttura cloud ed è quello che viene chiamato HOD. Condivide comparativamente un numero minore di nodi e quindi fornisce una maggiore sicurezza.

Importanza dell'utilizzo dei programmatori Hadoop

- Dai tipi di Hadoop Scheduler, dovrebbe essere chiaro dove risiede l'importanza dell'utilizzo di questi Hadoop Scheduler. Se stai eseguendo un cluster di grandi dimensioni con diversi tipi di lavoro, priorità e dimensioni diverse insieme a più client, scegli il giusto tipo di scheduler Hadoop per diventare importante.

- Ciò è importante in quanto garantisce l'accesso garantito al livello di capacità inutilizzato e l'utilizzo ottimale delle risorse dando la priorità ai lavori in modo efficiente all'interno delle code. Anche se questa parte degli scheduler di Hadoop è relativamente semplice in quanto l'utilizzo di programmatori equi è per lo più la scelta giusta se c'è una differenza tra il numero e i tipi di cluster in esecuzione all'interno di una singola organizzazione.

- Questo equo programmatore può ancora essere utilizzato per fornire e distribuire in modo non uniforme la capacità di pool di lavori ed è fatto in modo molto più semplice e configurabile. Il programmatore equo viene anche in nostro aiuto quando parliamo della presenza di tipi diversificati di lavori in quanto può essere utilizzato per fornire tempi di risposta più elevati per lavori relativamente più piccoli che si mescolano con tipi più grandi di lavori e il supporto per questi è incluso in l'uso interattivo di modelli.

- Gli scheduler di capacità sono utili quando si è più preoccupati delle code anziché del livello dei pool creati e anche del livello configurabile della mappa e della riduzione dei posti di lavoro sono disponibili e la coda può permettersi di ottenere una capacità garantita del cluster.

Conclusione

In questo post, leggiamo degli programmatori Hadoop, il loro significato, introduzione, tipi di programmatori Hadoop, le loro funzioni e anche imparato l'importanza di questi programmatori Hadoop. Quando ci si riferisce all'ecosistema e all'ambiente dei big data, gli scheduler di Hadoop sono qualcosa di cui spesso non si parla ma che detiene il massimo significato e che non può permettersi di essere lasciato così com'è. Spero ti sia piaciuto il nostro articolo.

Articoli consigliati

Questa è una guida per Hadoop Schedulers. Qui discutiamo dell'introduzione e dei primi 4 tipi di scheduler Hadoop con l'importanza di usarlo. Puoi anche consultare i seguenti articoli per saperne di più-

- Componenti Swing in Java

- JTabbedPane in Java

- Parola chiave protetta in Java

- JTextArea in Java