Differenza tra Apache Storm e Apache Spark

Apache Storm è un sistema di calcolo in tempo reale open source, scalabile, tollerante ai guasti e distribuito. Apache Storm si concentra sull'elaborazione del flusso o sull'elaborazione degli eventi. Apache Storm implementa un metodo a tolleranza d'errore per eseguire un calcolo o eseguire il pipelining di calcoli multipli su un evento mentre scorre in un sistema. Apache Spark è un framework di tecnologia di elaborazione cluster e velocissimo, progettato per il calcolo rapido sull'elaborazione dei dati su larga scala. Apache Spark è un motore di elaborazione distribuito ma non include un gestore di risorse cluster integrato e un sistema di archiviazione distribuito. Devi collegare un gestore cluster e un sistema di archiviazione di tua scelta.

Altre informazioni su Apache Storm vs Apache Spark:

- Apache Storm è un motore di calcolo continuo parallelo alle attività. Definisce i suoi flussi di lavoro in Directed Acyclic Graphs (DAG) chiamati topologie. Queste topologie vengono eseguite fino alla chiusura da parte dell'utente o al verificarsi di un errore irreversibile. Apache Storm non funziona sui cluster Hadoop ma utilizza Zookeeper e il suo lavoratore Minion per gestire i suoi processi. Apache Storm può leggere e scrivere file su HDFS.

- Apache Storm si integra con le tecnologie di accodamento e database già utilizzate. Una topologia Storm consuma flussi di dati ed elabora tali flussi in modi arbitrariamente complessi, ripartizionando i flussi tra ogni fase del calcolo, se necessario. Apache Storm si basa su tuple e flussi. Una tupla è fondamentalmente quali sono i tuoi dati e come sono strutturati.

- Il framework Apache Spark è costituito da Spark Core e Set di librerie. Spark core esegue e gestisce il nostro lavoro fornendo all'utente un'esperienza senza interruzioni. Un utente deve inviare un lavoro a Spark core e Spark core si occupa dell'ulteriore elaborazione, esecuzione e risposta all'utente. Abbiamo Spark Core API in diversi linguaggi di scripting come Scala, Python, Java e R.

- In Apache Spark, l'utente può utilizzare Apache Storm per trasformare i dati non strutturati mentre fluiscono nel formato desiderato. Devi collegare un gestore cluster e un sistema di archiviazione di tua scelta.

- È possibile scegliere Apache YARN o Mesos per il gestore cluster per Apache Spark.

- Puoi scegliere Hadoop Distributed File System (HDFS), Google cloud storage, Amazon S3, Microsoft Azure per il gestore delle risorse per Apache Spark.

- Apache Spark è un motore di elaborazione dei dati per le modalità batch e streaming con query SQL, elaborazione dei grafici e Machine Learning.

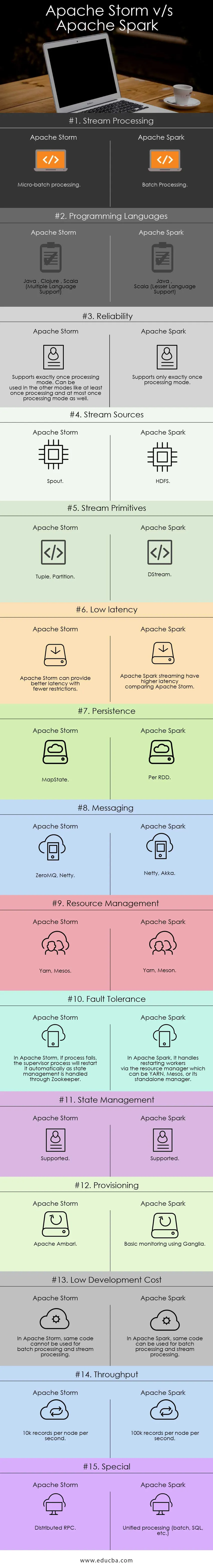

Confronto testa a testa tra Apache Storm vs Apache Spark (Infografica):

Differenze chiave tra Apache Storm vs Apache Spark:

Di seguito sono riportati gli elenchi di punti, descrivono le principali differenze tra Apache Storm e Apache Spark:

- Apache Storm esegue calcoli paralleli alle attività mentre Apache Spark esegue calcoli paralleli ai dati.

- Se il nodo di lavoro non riesce in Apache Storm, Nimbus assegna l'attività dei lavoratori all'altro nodo e tutte le tuple inviate al nodo fallito verranno scadute e quindi riprodotte automaticamente mentre In Apache Spark, se il nodo di lavoro fallisce, il sistema può ricalcolare da la copia rimanente dei dati di input e dei dati potrebbe andare persa se i dati non vengono replicati.

- La garanzia di consegna di Apache Strom dipende da un'origine dati sicura mentre in Apache Spark HDFS l'origine dati supportata è sicura.

- Apache Storm è un motore di elaborazione di flussi per l'elaborazione di dati di streaming in tempo reale mentre Apache Spark è un motore di elaborazione per scopi generici.

Caratteristiche di Apache Storm:

- Tolleranza ai guasti: dove se i thread di lavoro muoiono o un nodo si abbassa, i lavoratori vengono riavviati automaticamente

- Scalabilità: altamente scalabile, Storm può mantenere le prestazioni anche sotto carico crescente aggiungendo risorse in modo lineare in cui è possibile raggiungere velocità di throughput anche di un milione di messaggi da 100 byte al secondo per nodo per nodo

- Latenza: Storm esegue l'aggiornamento dei dati e la risposta di consegna end-to-end in secondi o minuti dipende dal problema. Ha una latenza molto bassa.

- Facilità d'uso nella distribuzione e nel funzionamento del sistema.

- Integrato con Hadoop per sfruttare i throughput più elevati

- Facile da implementare e può essere integrato con qualsiasi linguaggio di programmazione

- Apache Storm è open source, robusto e facile da usare. Potrebbe essere utilizzato in piccole aziende e grandi aziende

- Consente l'elaborazione del flusso in tempo reale in modo incredibilmente veloce perché e ha un enorme potere di elaborazione dei dati.

- Apache Storm ha intelligenza operativa.

- Apache Storm fornisce l'elaborazione dei dati garantita anche se uno dei nodi collegati nel cluster muore o i messaggi vengono persi

Caratteristiche di Apache Spark:

- Velocità: Apache Spark aiuta a eseguire un'applicazione nel cluster Hadoop, fino a 100 volte più veloce in memoria e 10 volte più veloce quando si esegue su disco.

- Elaborazione in tempo reale: Apache Spark è in grado di gestire dati di streaming in tempo reale.

- Usabilità : Apache Spark ha la capacità di supportare più lingue come Java, Scala, Python e R

- Valutazione pigra: in Apache Spark, le trasformazioni sono pigre in natura. Darà il risultato dopo aver formato un nuovo RDD da quello esistente.

- Integrazione con Hadoop: Apache Spark può essere eseguito indipendentemente e anche su Hadoop YARN Cluster Manager e quindi può leggere i dati Hadoop esistenti.

- Tolleranza ai guasti: Apache Spark fornisce tolleranza ai guasti usando il concetto RDD. Gli RDD Spark sono progettati per gestire l'errore di qualsiasi nodo di lavoro nel cluster.

Tabella di confronto tra Apache Storm e Apache Spark

Sto discutendo i principali artefatti e distinguendo tra Apache Storm e Apache Spark.

| Apache Storm | Apache Spark | |

| Elaborazione del flusso | Elaborazione micro-batch | Elaborazione in lotti |

| Linguaggi di programmazione | Java, Clojure, Scala (supporto per più lingue) | Java, Scala (Lesser Language Support) |

| Affidabilità | Supporta esattamente una volta la modalità di elaborazione. Può essere utilizzato in altre modalità come almeno una volta l'elaborazione e al massimo una volta anche la modalità di elaborazione | Supporta esattamente una sola volta la modalità di elaborazione |

| Sorgenti Stream | Becco | HDFS |

| Stream Primitives | Tupla, partizione | DSTREAM |

| Bassa latenza | Apache Storm può fornire una migliore latenza con meno restrizioni | Lo streaming di Apache Spark ha una latenza più elevata rispetto ad Apache Storm |

| Persistenza | MapState | Per RDD |

| messaggistica | ZeroMQ, Netty | Netty, Akka |

| Gestione delle risorse | Filato, Mesos | Filato, Meson |

| Tolleranza ai guasti | In Apache Storm, se il processo fallisce, il processo del supervisore lo riavvierà automaticamente mentre la gestione dello stato viene gestita tramite Zookeeper | In Apache Spark, gestisce il riavvio dei lavoratori tramite il gestore risorse che può essere YARN, Mesos o il suo gestore autonomo |

| Gestione statale | supportato | supportato |

| Approvvigionamento | Apache Ambari | Monitoraggio di base tramite Ganglia |

| Basso costo di sviluppo | In Apache Storm, lo stesso codice non può essere utilizzato per l'elaborazione batch e l'elaborazione del flusso | In Apache Spark, lo stesso codice può essere utilizzato per l'elaborazione batch e l'elaborazione del flusso |

| Portata | 10k record per nodo al secondo | 100k record per nodo al secondo |

| Speciale | RPC distribuito | Elaborazione unificata (batch, SQL, ecc.) |

Conclusione - Apache Storm vs Apache Spark:

Apache Storm e Apache Spark sono ottime soluzioni che risolvono il problema di ingestione e trasformazione dello streaming. Apache Storm e Apache Spark possono entrambi far parte del cluster Hadoop per l'elaborazione dei dati. Apache Storm è una soluzione per l'elaborazione in streaming in tempo reale. Ma Storm è molto complesso per gli sviluppatori nello sviluppo di applicazioni a causa delle risorse limitate.

Apache Storm può essere utilizzato principalmente per l'elaborazione Stream. Ma l'industria ha bisogno di una soluzione generalizzata in grado di risolvere tutti i tipi di problemi. Ad esempio Elaborazione batch, elaborazione interattiva dello stream ed elaborazione iterativa. Quindi, Apache Spark viene alla ribalta, che è un motore di calcolo generico. Questo è il motivo per cui la domanda di Apache Spark sta confrontando maggiormente altri strumenti da parte dei professionisti IT. Apache Spark è in grado di gestire diversi tipi di problemi. A parte questo Apache Spark è fin troppo facile per gli sviluppatori e può integrarsi molto bene con Hadoop. Apache Spark ti offre la flessibilità di lavorare in diverse lingue e ambienti.

Articolo raccomandato

Questa è stata una guida per Apache Storm vs Apache Spark, il loro significato, il confronto testa a testa, le differenze chiave, la tabella di confronto e le conclusioni. Puoi anche consultare i seguenti articoli per saperne di più -

- Iaas vs Azure Pass - Differenze che devi conoscere

- Apache Hadoop vs Apache Spark | I 10 migliori confronti che devi sapere!

- 7 Guida straordinaria su Informazioni su Apache Spark (Guida)

- Le 15 migliori cose che devi sapere su MapReduce vs Spark

- Hadoop vs Apache Spark - Cose interessanti che devi sapere