Differenza tra Hadoop vs Spark

Hadoop è un framework open source che consente di archiviare ed elaborare i big data, in un ambiente distribuito tra cluster di computer. Hadoop è progettato per scalare da un singolo server a migliaia di macchine, dove ogni macchina offre computazione e archiviazione locali. Spark è un cluster computing open source progettato per un calcolo veloce. Fornisce un'interfaccia per la programmazione di interi cluster con parallelismo dei dati implicito e tolleranza agli errori. La caratteristica principale di Spark è il cluster computing in memoria che aumenta la velocità di un'applicazione.

Hadoop

- Hadoop è un marchio registrato della base software Apache. Utilizza un semplice modello di programmazione per eseguire l'operazione richiesta tra i cluster. Tutti i moduli in Hadoop sono progettati con un presupposto fondamentale che i guasti hardware sono eventi comuni e dovrebbero essere trattati dal framework.

- Esegue l'applicazione utilizzando l'algoritmo MapReduce, in cui i dati vengono elaborati in parallelo su diversi nodi della CPU. In altre parole, il framework Hadoop è abbastanza in grado di sviluppare applicazioni, che sono inoltre in grado di funzionare su cluster di computer e potrebbero eseguire un'analisi statistica completa per una grande quantità di dati.

- Il nucleo di Hadoop è costituito da una parte di archiviazione, nota come Hadoop Distributed File System e da una parte di elaborazione denominata modello di programmazione MapReduce. Hadoop fondamentalmente suddivide i file in blocchi di grandi dimensioni e li distribuisce tra i cluster, trasferisce il codice del pacchetto in nodi per elaborare i dati in parallelo.

- Questo set di dati di approccio deve essere elaborato più velocemente e in modo più efficiente. Altri moduli Hadoop sono comuni a Hadoop, che è un insieme di librerie e utility Java restituite dai moduli Hadoop. Queste librerie forniscono un file system e astrazione a livello di sistema operativo, contengono anche i file e gli script Java necessari per avviare Hadoop. Hadoop Yarn è anche un modulo che viene utilizzato per la pianificazione dei lavori e la gestione delle risorse del cluster.

Scintilla

- Spark è stato creato sulla parte superiore del modulo MapReduce di Hadoop ed estende il modello MapReduce per utilizzare in modo efficiente più tipi di calcoli che includono query interattive ed elaborazione di flussi. Spark è stato introdotto dalla base software Apache per accelerare il processo del software di elaborazione computazionale Hadoop.

- Spark ha una propria gestione dei cluster e non è una versione modificata di Hadoop. Spark utilizza Hadoop in due modi: uno è lo storage e il secondo è l'elaborazione. Poiché la gestione dei cluster arriva dalla stessa Spark, utilizza Hadoop solo a scopo di archiviazione.

- Spark è uno dei sottoprogetti di Hadoop che è stato sviluppato nel 2009 e successivamente è diventato open source con una licenza BSD. Ha molte caratteristiche meravigliose, modificando alcuni moduli e incorporando nuovi moduli. Aiuta a eseguire un'applicazione in un cluster Hadoop, più volte più veloce in memoria.

- Ciò è reso possibile riducendo il numero di operazioni di lettura / scrittura su disco. Memorizza i dati di elaborazione intermedi in memoria, salvando le operazioni di lettura / scrittura. Spark fornisce anche API integrate in Java, Python o Scala. Pertanto, si possono scrivere applicazioni in più modi. Spark non solo fornisce una strategia di mappa e riduzione, ma supporta anche query SQL, streaming di dati, apprendimento automatico e algoritmi grafici.

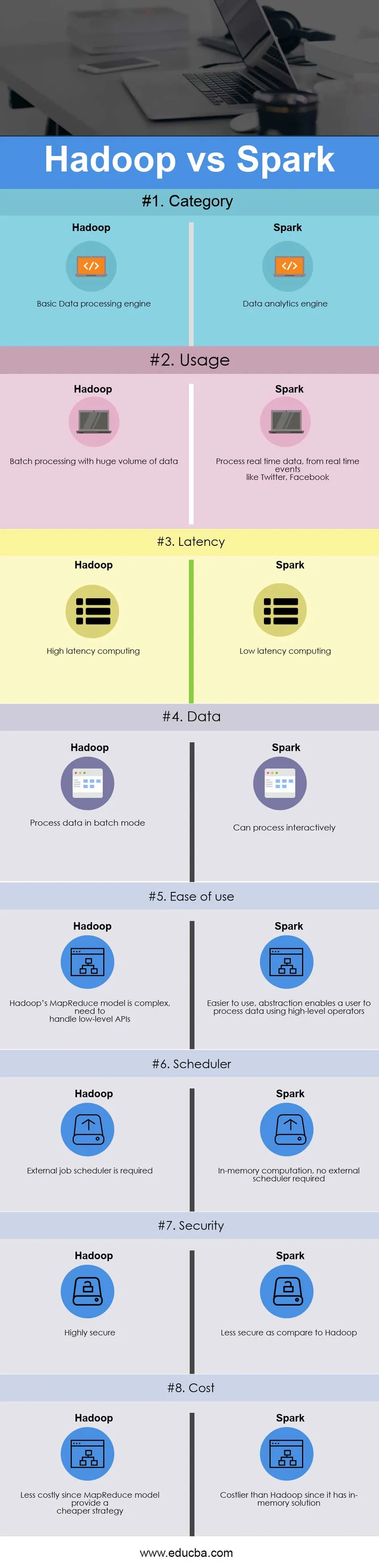

Confronto testa a testa tra Hadoop vs Spark (infografica)

Di seguito è la 8 differenza principale tra Hadoop vs Spark

Differenze chiave tra Hadoop vs Spark

Sia Hadoop vs Spark sono scelte popolari sul mercato; parliamo di alcune delle principali differenze tra Hadoop e Spark:

- Hadoop è un framework open source che utilizza un algoritmo MapReduce mentre Spark è una tecnologia di elaborazione cluster estremamente veloce, che estende il modello MapReduce per un uso efficiente con più tipi di calcoli.

- Il modello MapReduce di Hadoop legge e scrive da un disco, rallentando così la velocità di elaborazione, mentre Spark riduce il numero di cicli di lettura / scrittura su disco e memorizza i dati intermedi in memoria, quindi una maggiore velocità di elaborazione.

- Hadoop richiede agli sviluppatori di codificare manualmente ogni singola operazione, mentre Spark è facile da programmare con RDD - Resilient Distributed Dataset.

- Il modello Hadoop MapReduce fornisce un motore batch, quindi dipendente da motori diversi per altri requisiti, mentre Spark esegue batch, interattivo, Machine Learning e Streaming tutti nello stesso cluster.

- Hadoop è progettato per gestire in modo efficiente l'elaborazione batch, mentre Spark è progettato per gestire i dati in tempo reale in modo efficiente.

- Hadoop è un framework di elaborazione ad alta latenza, che non ha una modalità interattiva mentre Spark è una elaborazione a bassa latenza e può elaborare i dati in modo interattivo.

- Con Hadoop MapReduce, uno sviluppatore può elaborare i dati solo in modalità batch, mentre Spark può elaborare i dati in tempo reale tramite Spark Streaming.

- Hadoop è progettato per gestire guasti e guasti, è naturalmente resistente ai guasti, quindi un sistema altamente tollerante ai guasti mentre, con Spark, RDD consente il recupero di partizioni su nodi guasti.

- Ad esempio, Hadoop ha bisogno di un programmatore di lavoro esterno - Oozie per pianificare flussi complessi mentre Spark ha un calcolo in memoria, quindi ha un proprio programmatore di flussi.

- Hadoop è un'opzione più economica disponibile mentre la confronta in termini di costi, mentre Spark richiede molta RAM per funzionare in memoria, aumentando così il cluster e quindi i costi.

Tabella comparativa Hadoop vs Spark

Il confronto principale tra Hadoop vs Spark è discusso di seguito

| La base del confronto tra Hadoop vs Spark |

Hadoop |

Scintilla |

| Categoria | Motore di elaborazione dei dati di base | Motore di analisi dei dati |

| uso | Elaborazione batch con un enorme volume di dati | Elaborare dati in tempo reale, da eventi in tempo reale come Twitter, Facebook |

| Latenza | Elaborazione ad alta latenza | Elaborazione a bassa latenza |

| Dati | Elaborazione dei dati in modalità batch | Può elaborare in modo interattivo |

| Facilità d'uso | Il modello MapReduce di Hadoop è complesso, deve gestire API di basso livello | Più facile da usare, l'astrazione consente a un utente di elaborare i dati utilizzando operatori di alto livello |

| Scheduler | È necessario un programmatore di lavoro esterno | Calcolo in memoria, nessun programmatore esterno richiesto |

| Sicurezza | Altamente sicuro | Meno sicuro rispetto a Hadoop |

| Costo | Meno costoso poiché il modello MapReduce fornisce una strategia più economica | Più costoso di Hadoop poiché ha una soluzione in memoria |

Conclusione - Hadoop vs Spark

Hadoop MapReduce consente l'elaborazione parallela di enormi quantità di dati. Suddivide un grosso blocco in più piccoli da elaborare separatamente su diversi nodi di dati e raccoglie automaticamente i risultati su più nodi per restituire un singolo risultato. Nel caso in cui il set di dati risultante sia più grande della RAM disponibile, Hadoop MapReduce potrebbe superare Spark.

Spark, d'altra parte, è più facile da usare rispetto a Hadoop, poiché include API intuitive per Scala (la sua lingua madre), Java, Python e Spark SQL. Poiché Spark fornisce un modo per eseguire streaming, elaborazione batch e machine learning nello stesso cluster, gli utenti trovano facile semplificare la propria infrastruttura per l'elaborazione dei dati.

La decisione finale di scegliere tra Hadoop vs Spark dipende dal parametro di base - requisito. Apache Spark è un motore di calcolo cluster molto più avanzato rispetto a MapReduce di Hadoop, poiché può gestire qualsiasi tipo di requisito, ad esempio batch, interattivo, iterativo, streaming ecc., Mentre Hadoop limita solo l'elaborazione batch. Allo stesso tempo, Spark è più costoso di Hadoop con la sua funzionalità in memoria, che alla fine richiede molta RAM. Alla fine, tutto dipende dal budget aziendale e dai requisiti funzionali. Spero ora che tu abbia avuto un'idea più giusta di entrambi Hadoop vs Spark.

Articolo raccomandato

Questa è stata una guida alla differenza principale tra Hadoop vs Spark. Qui discutiamo anche le differenze chiave tra Hadoop e Spark con le infografiche e la tabella di confronto. Puoi anche dare un'occhiata ai seguenti articoli di Hadoop vs Spark per saperne di più.

- Data Warehouse vs Hadoop

- Splunk vs Spark

- Hadoop vs Cassandra - 17 differenze impressionanti

- Pig vs Spark - Qual è il migliore

- Prestazioni Hadoop vs SQL: differenza