Introduzione ai metodi del kernel in Machine Learning

L'algoritmo utilizzato per l'analisi del modello è definito come metodo del kernel in Machine Learning. In generale, l'analisi viene eseguita per trovare relazioni nei set di dati. Queste relazioni possono essere raggruppamento, classificazione, componenti principali, correlazione, ecc. La maggior parte di questi algoritmi che risolvono questi compiti di analisi del modello, Richiede che i dati in un rappresentante non elaborato, vengano esplicitamente trasformati in una rappresentazione vettoriale di caratteristiche. Questa trasformazione può essere effettuata tramite una mappa delle caratteristiche specificata dall'utente. Quindi, si può presumere che solo il kernel specificato dall'utente sia richiesto dal metodo kernel.

La terminologia Kernal Method deriva dal fatto che usano la funzione kernel, che consente loro di eseguire l'operazione in spazi caratteristici ad alta dimensione e impliciti senza la necessità di calcolare le coordinate dei dati in quello spazio. Invece, calcolano semplicemente il prodotto interno tra le immagini di tutte le coppie di dati nello spazio delle caratteristiche.

Questo tipo di operazioni sono più economiche dal punto di vista computazionale per la maggior parte del tempo rispetto al calcolo esplicito delle coordinate. Questa tecnica è definita "trucco del kernel". Qualsiasi modello lineare può essere convertito in un modello non lineare applicando il trucco del kernel al modello.

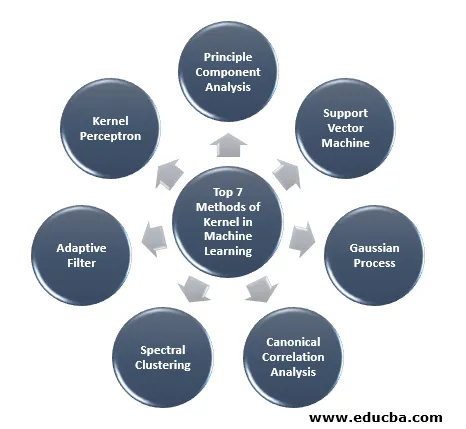

Il metodo del kernel disponibile nell'apprendimento automatico è l'analisi dei componenti principali (PCA), il clustering spettrale, le macchine vettore di supporto (SVM), l'analisi della correlazione canonica, la percezione del kernel, i processi gaussiani, la regressione della cresta, i filtri adattativi lineari e molti altri. Diamo una comprensione di alto livello di alcuni di questi metodi del kernel.

I 7 metodi principali del kernel nell'apprendimento automatico

Ecco i metodi di Kernel citati di seguito in Machine Learning:

1. Principio Analisi dei componenti

L'analisi dei componenti principali (PCA) è una tecnica per estrarre la struttura da insiemi di dati possibilmente ad alta dimensione. Viene prontamente eseguito utilizzando algoritmi iterativi che stimano i componenti principali o risolvendo un problema di autovalore. PCA è una trasformazione ortogonale del sistema di coordinate in cui descriviamo i nostri dati. Il nuovo sistema di coordinate è ottenuto mediante proiezione sugli assi principali dei dati. Un numero limitato di componenti principali è spesso sufficiente per tenere conto della maggior parte della struttura nei dati. Una delle sue principali applicazioni è quella di eseguire analisi di dati esplorativi per realizzare un modello predittivo. Utilizzato principalmente per visualizzare la relazione tra popolazioni e distanza genetica.

2. Supporto macchina vettoriale

SVM può essere definito come un classificatore per la separazione dell'iperpiano in cui l'iperpiano è il sottospazio di una dimensione inferiore allo spazio ambiente. La dimensione di questo spazio matematico è definita come il numero minimo di coordinate richieste per specificare qualsiasi punto mentre lo spazio ambientale è lo spazio che circonda l'oggetto matematico. Ora l'oggetto matematico può essere compreso come un oggetto astratto che non esiste in nessun momento o luogo ma esiste come un tipo di cosa.

3. Processo gaussiano

Il processo gaussiano prende il nome da Cark Friedrich Gauss perché utilizza la notazione della distribuzione gaussiana (distribuzione normale). È un processo stocastico che significa una raccolta di variabili casuali indicizzate dal tempo o dallo spazio. Nel processo gaussiano le variabili casuali hanno una distribuzione normale multivariata, cioè tutte le combinazioni lineari finite sono normalmente distribuite. Il processo gaussiano utilizza le proprietà ereditate da una distribuzione normale e quindi sono utili nella modellistica statistica. L'algoritmo di Machine Learning che prevede questo metodo del kernel utilizza la misura dell'apprendimento pigro e la somiglianza tra i punti per prevedere il valore dei punti invisibili dai dati di allenamento. Questa previsione non è solo la stima, ma l'incertezza a quel punto.

4. Analisi di correlazione canonica

L'analisi della correlazione canonica è un modo per inferire informazioni dalle matrici di covarianza incrociata. È anche noto come analisi dei variati canonici. Supponiamo di avere due vettore X, Y della variabile casuale che dicano due vettori X = (X1, …, Xn) e il vettore Y = (Y1, …, Ym) e che la variabile abbia correlazione, quindi CCA calcolerà una combinazione lineare di X e Y che ha la massima correlazione tra loro.

5. Clustering spettrale

Nell'applicazione della segmentazione delle immagini, il clustering spettrale è noto come categorizzazione degli oggetti basata sulla segmentazione. Nel clustering spettrale, la riduzione della dimensionalità viene eseguita prima del clustering in un numero inferiore di dimensioni, utilizzando l'autovalore della matrice di somiglianza dei dati. Ha le sue radici nella teoria dei grafi, dove questo approccio viene utilizzato per identificare le comunità di nodi in un grafico che si basa sui bordi che li collegano. Questo metodo è abbastanza flessibile e ci consente di raggruppare i dati anche da non grafici.

6. Filtro adattivo

Il filtro adattativo utilizza un filtro lineare che comprende una funzione di trasferimento, che è controllata da parametri variabili e dai metodi, che verranno utilizzati per modificare questi parametri secondo l'algoritmo di ottimizzazione. La complessità di questo algoritmo di ottimizzazione è la ragione per cui tutti i filtri adattativi sono filtri digitali. È necessario un filtro adattivo in quelle applicazioni in cui non sono disponibili informazioni preliminari sull'operazione di elaborazione desiderata o che stanno cambiando.

La funzione di costo viene utilizzata nel filtro adattivo ad anello chiuso, poiché è necessaria per le prestazioni ottimali del filtro. Determina come modificare la funzione di trasferimento del filtro per ridurre il costo della successiva iterazione. Una delle funzioni più comuni è l'errore quadratico medio del segnale di errore.

7. Kernel Perceptron

Nell'apprendimento automatico, il perceptron del kernel è un tipo del popolare algoritmo di apprendimento del percettrone in grado di apprendere le macchine del kernel, come i classificatori non lineari che utilizza una funzione del kernel per calcolare la somiglianza di quei campioni che non sono visti ai campioni di addestramento. Questo algoritmo è stato inventato nel 1964, rendendolo il primo studente di classificazione del kernel.

La maggior parte degli algoritmi del kernel discussi si basano sull'ottimizzazione convessa o sugli autovalori e sono statisticamente fondati. Le loro proprietà statistiche sono analizzate usando la teoria dell'apprendimento statistico.

Parlando delle aree di applicazione dei metodi del kernel è diverso e include geostatistica, kriging, ponderazione della distanza inversa, ricostruzione 3D, bioinformatica, chemioinformatica, estrazione delle informazioni e riconoscimento della scrittura.

Conclusione

Ho riassunto alcune terminologie e tipi di metodi del kernel in Machine Learning. A causa della mancanza di spazio, questo articolo non è affatto esaustivo ed è pensato solo per darti un'idea di cosa sia il metodo kernel e un breve riassunto dei loro tipi. Tuttavia, la copertura di questo articolo ti farà fare il primo passo nel campo dell'apprendimento automatico.

Articoli consigliati

Questa è una guida al metodo Kernel in Machine Learning. Qui discutiamo i 7 tipi di metodi del kernel in Machine Learning. Puoi anche consultare il seguente articolo.

- Kernel monolitico

- Clustering in Machine Learning

- Apprendimento automatico di data science

- Apprendimento automatico senza supervisione

- Filtri PHP | Come convalidare l'input dell'utente usando vari filtri?

- Guida completa al ciclo di vita dell'apprendimento automatico