Introduzione a Hadoop Framework

Prima di approfondire il quadro tecnico di Hadoop, inizieremo con un semplice esempio.

C'è una fattoria che raccoglie i pomodori e li conserva in un'unica area di stoccaggio, ora con la crescente domanda di verdure, la fattoria ha iniziato a raccogliere patate, carote - con la crescente domanda c'era una carenza di agricoltori e quindi hanno assunto più agricoltori. Dopo qualche tempo si sono resi conto che c'era una carenza nell'area di stoccaggio, quindi hanno distribuito le verdure in diverse aree di stoccaggio. Quando si tratta di recuperare i dati, tutti lavorano in parallelo con il proprio spazio di archiviazione.

Quindi, in che modo questa storia è legata ai big data?

In precedenza avevamo dati limitati, con il processore limitato e un'unità di archiviazione. Ma poi la generazione di dati è aumentata portando ad un volume elevato e a diverse varietà - strutturate, semi-strutturate e non strutturate, quindi la soluzione era quella di utilizzare l'archiviazione distribuita per ciascun processore, questo ha permesso un facile accesso all'archivio e ai dati di accesso.

Quindi ora possiamo sostituire le verdure come diversi tipi di dati e luoghi di archiviazione come i luoghi distribuiti in cui archiviare i dati e diversi lavoratori in ciascun processore.

Quindi i Big Data sono la sfida e Hadoop fa la parte della Soluzione.

HADOOP

1. Soluzione per GRANDI DATI: in quanto si occupa di complessità di volume elevato, velocità e varietà di dati.

2. Set del progetto open source.

3. Memorizza un enorme volume di dati in modo affidabile e consente enormi calcoli distribuiti.

4. Gli attributi chiave di Hadoop sono ridondanza e affidabilità (assolutamente nessuna perdita di dati).

5. Si concentra principalmente sull'elaborazione batch.

6. Funziona su hardware di materie prime - non è necessario acquistare alcun hardware speciale costoso.

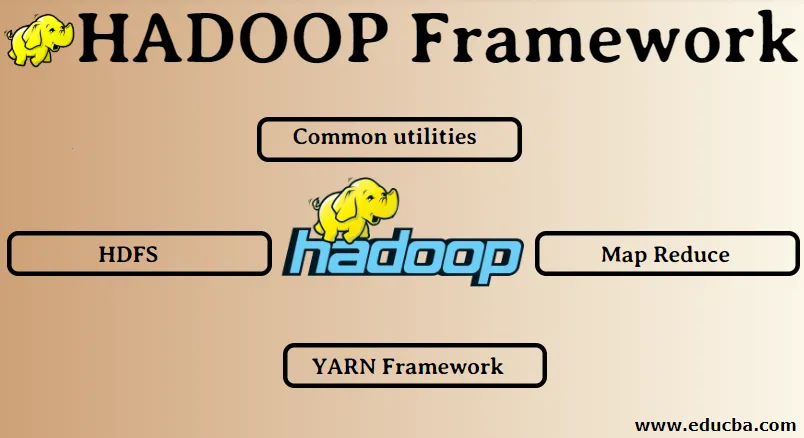

Quadro Hadoop:

1. Utilità comuni

2. HDFS

3. Riduzione della mappa

4. YARN Framework

1. Utilità comuni:

Chiamato anche il comune di Hadoop. Questi non sono altro che le librerie, i file, gli script e le utility JAVA che sono effettivamente richiesti dagli altri componenti di Hadoop per eseguire.

2. HDFS: Hadoop Distributed File System

Perché Hadoop ha scelto di incorporare un file system distribuito?

Comprendiamolo con un esempio: dobbiamo leggere 1 TB di dati e abbiamo una macchina con 4 canali I / O per ogni canale con 100 MB / s, ci sono voluti 45 minuti per leggere tutti i dati. Ora la stessa quantità di dati viene letta da 10 macchine ciascuna con 4 canali I / O ogni canale con 100 MB / s. Indovina il tempo impiegato per leggere i dati? 4.3 minuti. HDFS risolve il problema della memorizzazione di big data. I due componenti principali di HDFS sono NAME NODE e DATA NODE. Il nodo nome è il master, potremmo avere anche un nodo nome secondario nel caso in cui il nodo nome principale smetta di funzionare, il nodo nome secondario fungerà da backup. Fondamentalmente il nodo nome mantiene e gestisce i nodi di dati archiviando i metadati. Il nodo dati è lo slave che è fondamentalmente l'hardware delle materie prime a basso costo. Possiamo avere più nodi di dati. Il nodo dati memorizza i dati effettivi. Questo nodo di dati supporta il fattore di replica, supponiamo che se un nodo di dati si abbassa, l'accesso ai dati può essere effettuato dall'altro nodo di dati replicati, pertanto l'accessibilità dei dati viene migliorata e la perdita di dati viene impedita.

3. Riduzione della mappa:

Risolve il problema dell'elaborazione dei big data. Comprendiamo che il concetto di mappa si riduce risolvendo questo problema del mondo reale. La società ABC vuole calcolare le sue vendite totali, per quanto riguarda la città. Ora qui il concetto di tabella hash non funzionerà perché i dati sono in terabyte, quindi utilizzeremo il concetto Map-Reduce.

Esistono due fasi: a) MAP. b) RIDURRE

a) Mappa : in primo luogo, divideremo i dati in blocchi più piccoli chiamati mappatori sulla base della coppia chiave / valore. Quindi qui la chiave sarà il nome della città e il valore sarà il totale delle vendite. Ogni mappatore riceverà i dati di ogni mese che danno un nome di città e le vendite corrispondenti.

b) Riduci: otterrà queste pile di dati e ogni riduttore sarà responsabile per le città nord / ovest / est / sud. Quindi il lavoro del riduttore raccoglierà questi piccoli pezzi e li convertirà in quantità maggiori (aggiungendoli) per una particolare città.

Quadro 4.YARN: ancora un altro negoziatore di risorse.

La versione iniziale di Hadoop aveva solo due componenti: Map Reduce e HDFS. Successivamente si è realizzato che Map Reduce non era in grado di risolvere molti problemi relativi ai big data. L'idea era di allontanare le responsabilità di gestione delle risorse e di pianificazione dei lavori dal vecchio motore di riduzione delle mappe e assegnarle a un nuovo componente. Quindi è così che è entrato in scena YARN. È lo strato intermedio tra HDFS e Map Reduce che è responsabile della gestione delle risorse del cluster.

Ha due ruoli chiave da svolgere: a) Pianificazione dei lavori. b) Gestione delle risorse

a) Pianificazione dei lavori: quando viene fornita una grande quantità di dati per l'elaborazione, questi devono essere distribuiti e suddivisi in diversi compiti / lavori. Ora JS decide a quale lavoro deve essere data la massima priorità, l'intervallo di tempo tra due lavori, la dipendenza tra i lavori, verifica che non vi siano sovrapposizioni tra i lavori in esecuzione.

b) Gestione delle risorse: per l'elaborazione dei dati e per l'archiviazione dei dati abbiamo bisogno delle risorse, giusto? Quindi il gestore delle risorse fornisce, gestisce e mantiene le risorse per archiviare ed elaborare i dati.

Quindi ora siamo chiari sul concetto di Hadoop e su come risolve le sfide create dai BIG DATA !!!

Articoli consigliati

Questa è stata una guida a Hadoop Framework. Qui abbiamo anche discusso i primi 4 framework Hadoop. Puoi anche consultare i nostri altri articoli suggeriti per saperne di più -

- Database Hadoop

- Hadoop Ecosystem

- Usi di Hadoop

- Lavori dell'amministratore di Hadoop

- Amministratore di Hadoop | Competenze e percorso di carriera